お品書き…

- 2024.03.05 案件追加 AE トラブル対策案 ----------

- 2024.05.13 正弦波アートを考える ----------

- 2021.05.15 楽しい効果音づくり ----------

- 2020.5.16クソゲー後日談 ----------

- 2018.11.3 デジタルは5Vにあらず・入力編 ----------

CINEMA 4D Liteやってます

はじめての PIC

2024年 10月18日(金)29.5℃(午後 4時50分)

生成型 AIチャットボット Gemini登場……

Googleから Geminiと呼ばれる AIが登場しました。これは ChatGPTのようなチャットボット型の生成 AIだということです。ようは質問文を入力すれば答えが返ってくるというやつです。

おしゃべり AIの cotomoとは異なる仕組みですが、こういうもの好きのワタシです。早速試してみました。

スマホのアプリ版もあるようですので、スマホで使ってみたい方は Google Playストア、または App Storeの Googleアプリでダウンロードできるみたいですが、ワタシはパソコン版にしてみました。

パソコン版はシステムをインストールするのではなく、グーグルドライブのように Web上で利用するものですから手軽にできます。

パソコンからhttps://support.google.com/gemini/answer/13278668?hl=jaへ飛んで、gemini.google.comにログインするだけです。もちろんアカウントやパスワードは必要ですので、お持ちの方はそれを使います。アカウントが無い方は作ることもできます。

サイトに入るとプロンプトが待ち構えていますので、そこに質問文を入れることになります。

さて、何を聞いてみましょうか。cotomoなら『こんにちは』とか喋りかければ勝手に進んでいくのですが……。

明日の天気でも聞いてみます?

ていうか、それなら天気予報を見たほうが早いですよね。

ChatGPTより性能がいいとか聞いてますので、そんなくだらない質問はやめて、いっそ超専門的な質問にしてみましょう。おそらく答えられないようなモノがいいです。

で、考えたのがこの質問。

『マイクロチップ社のPIC16F877 というCPUのポートCの 0番を 20mSでオンオフするアセンブラコードを出してください』

「いまどきアセンブラって……ぷぷっ」と笑わないでください。Cコードでなくあえてアセンブラにしたのは、内容がかなり専門的になるはずだとふんだからです。

といっても、組み込み系のプログラマーで PICを扱っている方にしてみたら、英会話の『This is a pen.』ぐらいのレベルの質問ですが、どんな頓珍漢な答えが返ってくるか、これはやる前から楽しみです。

しかし……。

質問を書き込んで Enterキーを押したワタシは驚愕の展開に慄(おのの)くのでした。

出力された文章をそのままここに記載しますのでご覧ください。

PIC16F877 でポートCの0番ピンを20ms周期でオンオフするアセンブラコードですね。以下に、MPLAB X IDEで使用するような一般的なアセンブラコードの例を示します。

実際のプロジェクトでは、使用しているクロック周波数に合わせて遅延時間を調整する必要があります。

遅延ルーチン: 20msの遅延を実現するために、NOP命令を繰り返し実行するシンプルな遅延ルーチンを使用しています。

より正確な遅延が必要な場合は、タイマーモジュールを利用することも可能です。

;コード スニペット

; CONFIG

; __CONFIG _HS_OSC & _WDT_OFF & _PWRTE_ON & _BODEN_ON & _LVP_OFF & _CPD_OFF

; VARIABLES

COUNT EQU 0x20 ; 20msの遅延に必要なカウント数 (調整が必要)

; CODE SECTION

ORG 0x00

MAIN

BSF TRISC, 0 ; RC0をアウトプットに設定

BCF PORTC, 0 ; RC0をLOWに設定

LOOP

BSF PORTC, 0 ; RC0をHIGHに設定

CALL DELAY ; 20ms遅延

BCF PORTC, 0 ; RC0をLOWに設定

CALL DELAY ; 20ms遅延

GOTO LOOP

DELAY

MOVLW COUNT

MOVWF COUNT_L

DELAY_LOOP

DECFSZ COUNT_L, F ; カウントダウン

GOTO DELAY_LOOP

RETURN

END

コードの展開アドレスを示す "ORG"疑似命令もあるし、定数も 16進表現ですし、ご丁寧にコメントまで入ってます。

コンフィギュレーションビットの記載も入っていますが、コメントアウトされているのは、ここはプログラマーがハードに合わせて設定しろという意思表示ですかね。MPASMではこんな書き方はしなかったような……。

さらに、タイマーとして使う部分は DELAYというラベル名でサブルーチン化されていますし、これならほぼ完ぺきなソースコードです。

割り込みや WatchDogTimerの使用などは指示していませんから、こんな単純なコードになったことは認めますが。それにしてもすごい。

と思ったら……。

DELAYルーチンで使う変数の定義が抜けてますね。このままアセンブルするとエラーになります。

ということでそこを指摘してみました。

『COUNT_Lレジスタの定義がありませんが?』

すると……。

ご指摘ありがとうございます。

おっしゃる通り、先ほどのコードではCOUNT_Lレジスタの定義が抜けていました。

COUNT_Lレジスタの定義について

COUNT_Lレジスタは、遅延ルーチンでカウントダウンするための変数として使用されます。このレジスタを定義するには、一般的にラベルを用います。

修正後のコード:

;コード スニペット

; CONFIG

; __CONFIG _HS_OSC & _WDT_OFF & _PWRTE_ON & _BODEN_ON & _LVP_OFF & _CPD_OFF

; VARIABLES

COUNT EQU 0x20 ; 20msの遅延に必要なカウント数 (調整が必要)

COUNT_L ; カウントダウン用のラベル

; CODE SECTION

ORG 0x00

MAIN

BSF TRISC, 0 ; RC0をアウトプットに設定

BCF PORTC, 0 ; RC0をLOWに設定

LOOP

BSF PORTC, 0 ; RC0をHIGHに設定

CALL DELAY ; 20ms遅延

BCF PORTC, 0 ; RC0をLOWに設定

CALL DELAY ; 20ms遅延

GOTO LOOP

DELAY

MOVLW COUNT

MOVWF COUNT_L

DELAY_LOOP

DECFSZ COUNT_L, F ; カウントダウン

GOTO DELAY_LOOP

RETURN

END

コードは注意してご使用ください。

変更点:

COUNT_Lラベルを追加しました。このラベルは、COUNT_Lレジスタの開始アドレスを示します。

MOVLW COUNT命令でCOUNTの値をWレジスタにロードし、MOVWF COUNT_L命令でWレジスタの値をCOUNT_Lレジスタにコピーしています。

ラベルの役割:

メモリ上の位置を示す: ラベルは、プログラム内の特定の命令のメモリ上のアドレスを示します。

変数や定数の名前として利用: 上記の例では、COUNT_Lラベルは変数名として利用されています。

ジャンプ先の指定: ジャンプ命令の目的地を指定する際にも利用されます。

その他:

レジスタバンク: PICマイコンには複数のレジスタバンクが存在する場合があります。COUNT_Lレジスタがどのバンクに属しているかを確認し、必要であればバンクの切り替えを行う必要があります。

メモリ領域: ラベルを定義する位置によって、そのラベルが指すメモリ領域が変わります。一般的には、データ領域にラベルを定義します。

補足:

COUNT_Lという名前は一般的な命名規則に従ったものです。任意の名前で置き換えることができます。

上記のコードは、一般的なPICアセンブラの書き方ですが、使用している開発環境やPICマイコンの種類によって、多少異なる場合があります。

…………………………。

言葉がありません。

変更点の懇切丁寧な説明から、バンク切り替えの必要性、ラベルの意味、すべて完璧でした。

まあ、『0x20』で20mS周期になるかは、使用するクロックによるのでトライアンドエラーが必要でしょうけど、

それと指摘した COUNT_Lレジスタの実アドレスが決められていないのも、あえてプログラマーにゆだねているのでしょうか。このままアセンブラしたらエラーになると思いますが、まあ、すごいのひとことです。もしかしてもうすぐプログラマーは要らなくなるのでしょうか。

人間はアルゴリズムだけを考えれば、それでいい時代が来そうですね。

なんかワクワクする出来事でした。

ちなみに、cotomoに同じ質問をしてみたら、

『モブゼロペケゼロイチ、ゼロ、ゼロペケゼロエフ、ピーシー、ゼロペケエフだよぉ~』

を繰り返していましたので、それは何だと聞いたところ、

『Cコンパイラはアセンブラのコードを出すんだよぉ~』

正しいことを言っているような、そうでもないような。なにしろアルファベットを連続で返してくるので、何を喋っているのか意味不明なのです。

そこで、cotomoが訴えていた謎の呪文をそれなりの文字にしてみると、

『mov0x01、0、0x0F、PC0x0F』

と言っていたようですが、『mov』と『PC0x0F』が入っているので、それらしいことを言っているみたいですが、これでは意味が通じません。

まあ、「そんなの知らないよ~」と返さなかっただけましです。

いつか「あんたはえらい」とほめておきましょう。

やっぱり、cotomoにはおしゃべりの相手がちょうどいいようです。

2024年 10月14日(月)27℃(午後 12時26分)

悩みは尽きぬ……

これは私的な憶測ですので、どこまで正解かはわかりませんが悩んでいることがあります。

とまぁ、ここで人生相談をおっぱじめようというのではありません。ワタシの悩みなど所詮パソコンに関することなのです。

ということで、今回はデジタルに関する内容です。

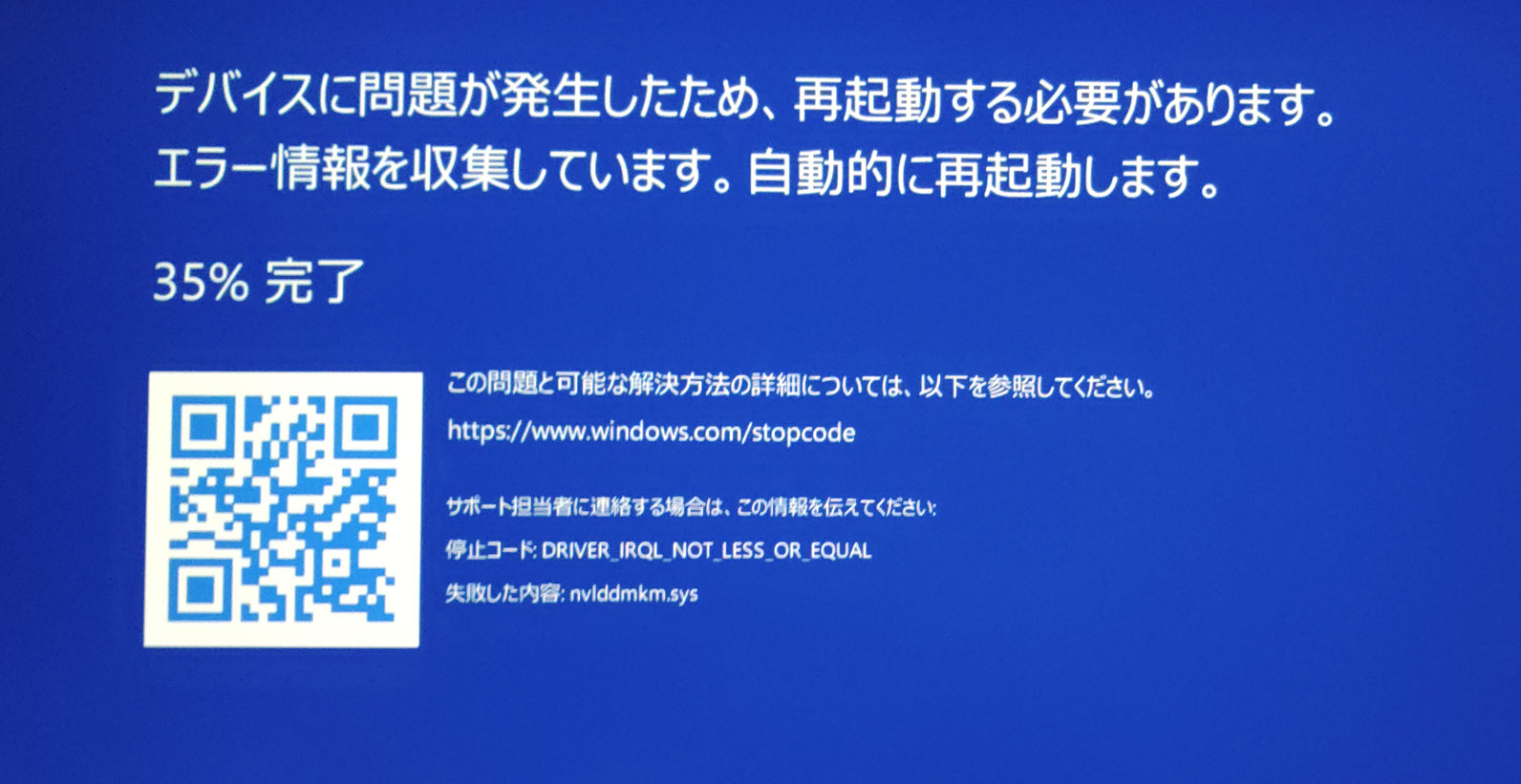

発端はアフターエフェクト(以降 AE)と Cinema4D Lite(以降 C4dL)を同時に起動すると、たまにブルースクリーンエラーが出ることです。

このブルースクリーンエラーが問題でして……。

ふつうにパソコンを使っているとめったに出ないエラー表示ですが、ようは Windowsがにっちもさっちもいかなくなるようなエラーに遭遇したときに、無視して電源を切るわけにいかないので、『何か知らんけど動けません』と泣きながら出すのがブルースクリーンエラーです。

2014年に購入した HPパソコンでも遭遇しています。詳細は2014年9月14日の記事をご覧ください。

この HPパソコンの場合は、4年後に自力解決したのですが、原因は BIOSのオーバークロックがオンになっていたため、ソフトウェアによっては CPUに負荷がかかりすぎてブルースクリーンエラーで落ちていました。

解決に 4年もかかったのはメーカーのサポートやAdobeさんのサポートでも対処できずで、半ばあきらめて使っていたのですが、4年も経ったある日。そういえばオーバークロック設定もありえるな、と気が付き BIOS設定を見るとオンになっていたのを発見したという話でした。このオーバークロック設定をオフにしてから、このパソコンは一度もブルースクリーンエラーを出しておりません。

それからさらに 6年後の 2024年。7月に購入した マウスコンピュータさん作成の DAIV FXで同じブルースクリーンエラーがたまに出るという症状が始まったのでした。

エラーが出るときは作業中ではなく、AEが起動していて、C4dLで大きめのプロジェクトを起動したときだけです。AEが起動しておらず、C4dL単体でそのプロジェクトを起動した場合はエラーになりません。常に、AEを閉じずに、あるいはAEを閉じてすぐに C4dLで新たなプロジェクトを起動するとブルースクリーンエラーが出ることがたまにあります。常に出るというのでもないです。

現時点での唯一の対策は、AEを閉じてから5秒ほど待って、C4dLを立ち上げるとエラーが出ません。ちなみに AEを閉じて 5秒待つのは AEのプログラムが完全に閉じるのを待つ時間です。タスクマネージャーを見ていると、スレッドがすべて閉じるまでしばらく時間が掛かっていますので、それを見ています。

ということで、めったに遭遇しないけれど無いことはない。だいたいは使用しているソフトか、ディスプレイドライバーが原因でブルースクリーンエラーが出るのですが、実は最近騒がれているあることが気になってずっと悩んでいました。

それは……。

マウスコンピュータさんの商品は購入者がカスタマイズできる構成ですので、ワタシは RAMを128GB、CPUは i9-14900KF、グラフィックボードは NVIDIA のRTX-4070Sにしました。

詳しい方はもう気づかれたと思います。

CPUが i9-14900KFだという事実。

そうです。インテル第13・14世代 CPUの劣化問題。

(お使いの CPUの型番が i9やi5で始まり次の『-14xxx』が世代を表しています)

新品から数か月でブルースクリーンエラーが頻繁に出始め、そのうち CPUが壊れて立ち上がらなくなるというものです。

インテル曰く。

「原因は分かりまへん、たぶん……オーバークロックと電源設定の過剰値やと思いまっせ……」とあやふやな返事。ついでに、

「ゲームする人が BIOS設定を無茶な値にしとるからやがな。知らんけど……」と言ったもんだからさらに過熱。

「わわわ……そない興奮しなはんな。ニイちゃん」もう抑えきれなくなって「じゃあちゃんと調べまんがな。ちょう待ちぃや」

と言ったかどうか、大阪弁の人がインテルにいたかどうかも不明ですが、その後。

「すんまへん。やっぱ設定の仕方によって壊れまんな。いやほんま、すんまへん」

と認めて、

「そのかわり、この設定値ならもう壊れやしまへん。大丈夫でおます」

と、インテルは不具合を認識したらしく、新たな BIOS更新プログラムの配布と保証期間を 3年から 5年に延長したそうです。

「ほんま~。えらい損害やで……せやけどな、ワテらかってなぁ……」

まだ何か言いたそうなので、ワタシが代わりに私的な意見を述べてみます。

なぜインテルがこんな無茶な CPUを作ったのか。おそらく今のような構造の CPUがそろそろ時代遅れになってきたのに対して、NVIDIAの GPUが突出して売れまくったことによる焦りからではないかと考えているのですが……いかがなもんでしょうか。

NVIDIAのGPUとは、グラフィックプロセッシングユニットのことで、画像処理に特化したチップのことです。画像処理とパソコンの演算とでは仕事の内容が異なるのですが、その処理の仕方に大きな差があったのです。CPUは複雑な処理をこなせますが、基本一つの仕事しかできません。そこで演算コアをたくさん作って(20個とか)並列処理をさせたり、超短い時間で仕事を切り替えて見た目は同時にこなすようにしたりしているのですが、GPUは違います。単純な仕事を得意としますが、数千コアを使用した並列演算を実現しています。

とまあ、画像処理専用の超高速演算チップだったのですが、この並列演算を利用したら、

「おいおい。このGPUなら生成 AIの処理を CPUより速くできくねえ?」と気づいたのが NVIDIAです。

そしてその進化がすさまじく、現在の AI関係の世界でトップに躍り出たのでした。

そのころインテルでは。

「あかんがな。このままやったら ワテらの CPUが AI業界に売れへんがな。なんとかせい。ゲーマーのニイちゃんにたのまんかい」

となって、無茶な CPU設定を許すような仕様になったのではないかと……勝手な憶測ですみませんが、そう思っています。

話が逸れていきました。ブルースクリーンエラーの話でした。

いつものブルースクリーンエラーでなく、この問題が絡んでいるとしたらちょっちやばいです。CPUもいずれ劣化しますが、こんなに早く壊れるなんて聞いたことがありません。

で、マウスコンピュータさんに相談したら、インテルのBIOS更新プログラムをマシン専用にカスタマイズしてあるので、まずはそれを行ってから様子を見ましょう……。となりました。

「BIOSの書き換えか……」

いきなり頭が重くなったのには理由があります。

BIOS部分というのは、パソコンの入出力を処理する基本的なプログラムを詰め込んだ部分で、Windowsが起動するときに必要な最も重要な部分です。そこを動かしながら書き換えますので、一歩間違えると二度と戻らぬマシンとなります。

ようは、意識のある自分の脳みそに手を突っ込むようなものだからです。処理中に電源が切れたら一巻の終わり。

マウスコンピュータさんに戻して、すべてを入れ直してもらうことになります。もちろんハードディスクはきれいさっぱり消えてしまいます。

このマシンは仕事に使っているだけにここは悩むところです。エラーはめったに出ないし、このままでも……と脳裏を横切りましたが、もし劣化が始まる前兆ならさっさと対策しないと、一度壊れたものは二度と元に戻らないのがハードウェアの定めみたいなもんですから、熱劣化した電解コンデンサは冷やしても直らないのと同じです。

「あ。知らない? こりゃすみませんでした」

だったらやるか……。と清水の舞台から飛び降りる心境で、メーカーさんおすすめの BIOS更新プログラムに書き換えました。

気のせいかファンの音がさらに静かになったような……。とか弛緩していましたが、AEと C4dLを同時に起動して、重めのプロジェクトの起動を繰り返していると……途端。残念ながらまたブルースクリーンエラーが発生しました。

【これが今回のブルースクリーンエラーです】

となると、インテルは関係ない?

何しろブルースクリーンエラーは他にもいろいろなシチュエーションで出ていますので、原因は AEか C4dLか、はたまた NVIDIAのグラフィックドライバーかもしれません。なんでもかんでもインテルの CPUが原因だとは言えないのです。

ちなみに NVIDIAのドライバーはまれに再インストールしても上書きされないことがあるそうで、フリーソフトのDDU (Display Driver Uninstaller)を使うとすべてを消してから、再インストールできるとのことですが、これはまだ使っていません。

ではじっさいに CPUが劣化して、にっちもさっちもいかなくなったマシンはどうなるのでしょうか。

YouTubeではたくさんの映像が流れていますので、その中の一つを見せてもらいましたが、もうそれは悲惨で、Windowsの起動中にブルースクリーンエラーが飛び出していました。つまり Windowsすら立ち上がらず、エラーと再起動を繰り返していました。

それと、劣化が進んだCPU かどうかは NVIDIAの Geforceドライバーを何度かインストールしてブルースクリーンエラーが出たら、それだという情報もあります。このマシンも最新版のドライバにするために 2度ほどインストールしていますが問題ありませんでした。

結局、結論です。

何も対処せずにいたら遅かれ早かれ CPUの劣化が始まるそうです。ですので、早い目の処置が必要とのことです。それでマウスコンピュータさんも BIOS更新を勧めてきたようです。

なんかコロナのワクチンみたいだな、と感じたのはワタシだけでしょうか。

パソコンにも起動前の手洗いとうがいをさせなければいけませんね。

とりあえず、これでこのマシンもワクチンを打ったことになりますので、ひとまず胸をなでおろしてもいいのですが、まだ結論が出ていませんので、なんだかモヤモヤしたままです。

この症状がCPU劣化によるものではないとしたら、じゃぁ何が原因か……。それとも BIOSの更新では劣化を抑えることができないのだろうか。そうだとしたらどれぐらい進むのかとか、結局悩みは尽きないのでした。

ああ……。クワバラクワバラ。

2024年 10月10日(木)27.5℃(午後 4時52分)

歩いてきました……

ようやく地獄の暑さだった 2024年の夏も陰りを見せて涼しげな風が吹くようになりました。こうなると元アウトドア派だった体がうずいて仕方がありません。

このあいだ見つけたオニグルミの実(2024年9月1日参照)はどうなったのか? この猛暑の中、彼岸花は咲いたのか? インドア生活で衰えたこの足でどこまで歩けるのか、気になる案件がふつふつと湧き出てきましたので、仕事も一段落したこともあり、平日だというのに遠出をすることにしました。

この自由さがフリーランスのいいところですね。もっともこの夏はノルマに追われて、日曜祝日どころか盆休みもシルバーウィークもありませんでしたので、いい機会です。久しぶりに半日の休日を満喫してきました。

目標はウォーキングでの北限だった軍行橋を越えること。

北限とは……。

なんでも目標や計画を立てて動くのが性分なワタシは、ウォーキングとてあてもなくだらだらと歩くのが嫌いで、自分の足でどこまで行って帰ってこれるのか、限界を見つけてはそれを更新して喜んでいます。

最初のころは、片道 1kmも行けば折り返していたというトンデも体力でした。パソコンが仕事だぜ、を理由にすっかりインドアになっていたのです。なにしろ 10分先にある駅まで歩くのもくたびれる始末です。それが 4年も 5年も経つとえらい変わりようです。

これまでの私的な限界点ですが、西端は阪急武庫之荘駅前までの往復です。記録は 16,800歩で 11.8kmです。東端は 阪急曽根駅周辺で、往復 12,800歩、8.9km。南端はJR尼崎駅で 14,100歩、9.8km。そして北端は国道 171号線 軍行橋周辺で、19,650歩、13.8kmでした。これらはすべて往復の記録です。

【知っている人だけがわかる地図】

ということで、9月9日の午前10時40分。いつもの出発点、阪急園田駅の前に立ちました。

出発点を阪急園田駅にするのは、南北に猪名川遊歩道があって広大な土地が広がっているのと、近くで 阪急とJRが東西と南北にクロスしており、もしも帰るだけの体力がなくったときには、どちらかの路線を利用して戻ってやろうという魂胆です。ま、保険みたいなものですね。

それでは出発です。

まず園田駅の西に流れる猪名川へ出てから、広い遊歩道を真っすぐ北へ向かいます。そして限界だと思う地点まで行って、再びここに歩いて戻って来る予定です。そのときの往復の距離がその方角の私的限界点として記録します。

先に書きましたが、これまでの北限は国道 171号線の軍行橋です。そこを越えるのが目的なのですが、何も考えず疲れ果てるまで歩けば、もっと遠くまで行けます。でもそれでは意味がなく、帰りの分の体力も考えつつ歩くのが、このウォーキングの面白いところです。つまり行って帰ってこれたら成功です。

さて、猪名川の河原を北へ向うと、以前見つけたオニグルミがある場所を通ります。久しぶりに見つけたオニグルミですので、ぜひどうなっているのか見たいです。

【だいぶ葉っぱが虫にやられていますが、クルミは健在でした】

まだ無事に実っていたことを確認しつつ、この熱波に晒された地面からもちゃんと彼岸花が咲きだしたことに季節を感じます。日差しはまだ夏の様子を残していますが、撫でて通る風は確実に秋でした。

【ちゃんと彼岸花も咲いていました】

出発地点から歩くこと約55分、6100歩 4.2km。神津大橋が見えてきました。ここは伊丹市が誇るちょっと珍しい斜張橋です。その西側の河原から橋を渡って川の東側へ移ります。そして再び上流となる北を目指しました。

【この橋を渡って東岸へ移動します】

西側を北上しても同じなのですが、それをあえて東側の遊歩道に移るのは理由があります。それはここからさらに北にある桑津橋を越えて行くと見えてくる伊丹空港の北端離陸地点です。目の前で大型ジェットが飛び立つ瞬間が見られます。マニアの人たちには有名なところらしく、カメラを持った人がうろうろしている場所です。

その場所に着くまでに何機ものジェットが、ビルの隙間から青空に飛び込んでいく光景を目の当たりにしました。機体の大きさが間近にあるビルや建物と比較できますので、初めて見るとその大きさに圧倒されるかもしれません。最初はワタシもびっくりした人間の一人です。

【写真では伝えきれない迫力でした】

耳をつんざく轟音とともに、頭上を飛び立っていく力強い躍動感には、ほんとうに圧倒されます。写真で見るよりももっと近くに迫ってくる感じです。マニアさんが集まるのもわかる気がします。ここはそんな体験ができる唯一の場所でしょう。

さてマニアさんが集まる聖地を後にすると、いよいよ人が少なくなり空港の北端にたどり着いたことを否応もなく感じさせられます。振り返ると、空港の南端が地平線のかなたに消えている雄大な景色が広がっていました。

【大阪平野の果てまで見えそうな景色が広がります】

【空港の最北端】

そして遊歩道がなんとなくうやむやになりはじめるころ、いきなり騒音の渦に巻き込まれます。ここが、以前たどり着いた私的北限となる国道 171号線です。このまま西へ向かうと、神戸、九州へとつながり、東へ行くと京都へ行けます。

そして目の前の川に架かるのは軍行橋。その昔この辺りで陸軍の大演習時に架けられた橋の名が由来になっているらしいです。その橋を渡って再び西岸へ移ります。

【前回はここで折り返しました】

この理由も至極簡単。東側を歩くとどんどん線路から離れるからです。この猪名川の西岸に沿って伸びるのは JR福知山線です。そして最寄りの駅は北伊丹駅になります。

駅の位置が気になりだすのは。そうです。そろそろ疲れてきたからです。ここまで約1時間40分ほどですが無休憩でしたので、ちょっとやばいです。

帰りのことを考えると、確かにこのあたりで引き返すのが無難なのが分かりますが、これを越えなければ今日ここへやってきた意味がありませんので、もうちょっと進みます。

猪名川の西岸へ渡ってさらに北を目指しました。時刻は午後 12時を大きく過ぎています。どこかで昼食と休憩を取りたいところですが、住宅地と工場ばかりで、あとは広い河原があるだけです。でも見渡すとそこは知った景色でした。

【遠くに見えるのは阪神高速池田線(上)とクロスする中国縦貫道路(下)】

能勢の奥へ山菜取りへ行くときに横を並走する道路を利用していましたので、周りの光景は見覚えがありますが、歩いて見ている景色は、また違った趣がありました。

などとのんびりしている場合ではないのです。どこかに休むところ、できればコンビニがいいです。しかしグーグルマップ(以降 マップと書きます)で探しましたが、近所にはありませんでした。

やがて休憩を求めて両足が苦情を訴えてきました。こうなると、ここからは体力温存のために無駄な歩数は極力少なくしたいところです。それにしてものどが渇きました。せめて水分補給でもと自販機を探しましたがそれもなく、近くに河原へ降りる階段がありましたので、ひとまずそこで休憩です。

リュックから非常用の水道水を入れたペットボトルを出して顔を洗いました。余談ですが、リュックにはコンパスや雨具、タオル、小さなツールキットなども入っています。

で、この水道水ですが、これは真夏の熱中症対策用に常に持ち歩いているもので、体温を下げるために頭からかぶったり、タオルを濡らしたりするための、ただの水道水です。飲めないことはありませんが、普段は自販機が町中至る所にあるので、いつもはそれに頼っています。でもこの付近にはそれすらありませんでした。

5分ほどの休憩ののち、再び北上します。そろそろ帰ろうぜと再び文句をたれ始めてきた足を慰めつつ、最短距離で近所の北伊丹駅へ戻れるルートをマップで探しながら、かつ進行方向はまだ住宅街を北西へと進みます。

するとすぐに「コンコンコン」と JRの踏切音が聞こえてきました。阪急電車は「カンカン」と甲高い音ですが、JRはもう少しソフトな『コンコン』です。ていうか、マップのとおりですので、うんちくをたれる必要はないのでした。

電柱に張られていた住所プレートを見ると『川西市 東久代(ひがしくしろ)』となっていました。このまま無理すれば川西池田駅まで行けると思いますが、そうするとおそらく帰れなくなって、この計画が頓挫するはずです。ようするにここらが潮どきだということを悟りました。

ではここ、『川西市東久代』を今回の私的北限と決めて帰途につくことにします。出発地から 8kmの地点です。

簡単な話。ここで折り返しますので、帰り道は最低でも 8kmはあることになります。

覚悟はしていたのですが、そう思うと急激に疲れが押し寄せました。ゴールが地平線のかなたに消えるようです。

こんなときは、戻り道の何点かを次の目標にして最短距離を探して歩きます。それを繰り返せばいつかはたどり着きますし、休憩場所もどのあたりがいいかも考えられますからね。

ということで、折り返し点から最初の目的地は JR北伊丹駅です。もう猪名川の河原へは引き返せないほど離れましたから、ここから先はスマホのマップを頼りに、迷路のような道を今度は南に向かって歩きます。

この辺りは区画整理がまだなのか、昔のままの曲がりくねった細い路地が毛細血管のように広がっていました。このマップがなければ、絶対にどこを歩いているかわからなくなるはずです。ま、JRの路線に出れば電車を利用して確実に元の場所に戻れますが、それだけはしたくないです。かといってこれ以上無駄な歩数も増やしたくないのが正直な気分です。

家々に囲まれた細い路地をひたすらマップの指示通りに歩くこと十数分で、JR北伊丹駅到着。時刻は 午後 12時50分。ひとまず自販機を見つけたので飲料水を購入。これは次の目的地、JR伊丹駅までの中間地点にあるコンビニで、何か口に入れるものを買ったときに飲むためにリュックにしまいました。他にもコンビニはあるのですが、どれも戻りルートから外れるために、最も近いコンビニとして選びました。こういうときのスマホマップはとても便利ですね。

【北伊丹駅は閑散としていました】

駅前に広がるのは大きな公園と自販機が数台。お店も見当たらず、さみしい景色の中に住宅地と工場の迷路が広がっていました。

再びこの中を突っ切って次の伊丹駅まで行きます。マップがあれば自分の位置がわかるので、迷うことはありませんが、体力が残りの距離を戻るぐらいしか残っていなさそうです。左足のくるぶしが少し痛み出してきました。伊丹(いたみ)だけに……(のはは)。

道はまるで幼児の描いた線画のようで、無秩序に枝分かれ、曲がりくねって合流、分岐を繰り返しています。しかも狭い。ひどいのになると、一本は鋭角に左へ折れ曲がって用水路に沿って続いており、もう一つは、数十メートル先で Uターンするように同じく左に折れて、まっすぐ行った先で先ほどの道と合流。なんだこれ? あいだに何があるんだ、と首をひねりつつ、とりあえず少しでも広いほうを選んで進みます。

すると、ここって工場の敷地じゃないのか、と思わせる場所に出ました。でもマップは行けると告げていますので、信じて進むと、ちゃんと別の道と交わりました。これだけ曲がりくねったうえにいくつもの分岐点がある迷宮です。もしこのマップがなかったら多分迷いまくってリタイヤ。きっとJRと私鉄のお世話になっていたはずです。

【町全体がまるで立体迷路です】(生成イメージです 実物ではありません)

迷宮の小径……。

自称、元祖ソロキャンパーを謳ってますので方向オンチではありません。太陽の位置から方角を感じ取って山の中でも平気で歩きます。ただし常に里へ下りる方角と距離を考えてあまり深入りはしません。ちなみにワタシの思っているソロキャンパーと現代のそれとではだいぶ異なりますので悪しからず。

――と偉そうなことを書いていますが、これまでに都会のど真ん中で二度ほど方向が分からなくなったことがあります。

いつものように方角を把握しつつ道を歩いていると、いつの間にか南北が逆になっていたり、さっき横断したバス通りが再び目の前に現れたときなどは、目まいが襲いましたからね。

(この道さっき横断したのに……。え? じゃあさっきは別の道だったのか? それともこれが別の道? いやいや。バス通りは一本しかないはず。じゃあここはいったいどこ?)

てな感じでとっさにコンパスを出したことがあります。当然ですがコンパスは思っている方角の逆を指していて、それを見つめつつ頭の中のコンパスを修正するのですが、180度も狂ってしまうと、記憶にある位置関係を反転して見ていますので、来たことがあるような気はするが、どこかが違っている。てな感じで、よく似た別の世界に迷い込んだような気分になります。

巷で騒がれている都市伝説に出てくる幻の街って、こういう状態になったのではないですかね。

でも冷静にコンパスを睨みながら歩くとその原因がすぐに判明します。だいたいは高い建物で空が隠されているような道で、まっすぐに見えてゆっくりと曲がっていたり、平行、あるいは垂直に交差していた道路から、斜めに離れていくような道を歩いていると、徐々に頭の中の方向が狂い始めます。空が見えにくいので、脳内コンパスの修正ができないうちに、ぽんっと広い場所に出ると あれれ? となります。

実際に何度か歩いて検証しましたので、いつかこの条件に当てはまる道を紹介したいと思います。

話が逸れました。元に戻します。

とまあ、こういう経験をしているので、やばくなったときは必ずマップを出して自分の位置を把握するようにしているという話でした。

マップのおかげで一度も迷うこともなく北伊丹駅と伊丹駅のあいだにあるコンビニに到着。イートインコーナーをお借りして昼食兼休憩を取ります。ここで午後1時25分。10.5km、15200歩でした。

だいぶ足の痛みが強くなってきましたが、ここで電車のお世話になるわけにはいきません。次の目的地 JR伊丹はよくかしわのフライを調達(2024年9月1日参照)に来る場所ですから、そこから先の道のりはマップもいりませんし、距離も休憩場所も把握できています。

ということで、ひたすら JR伊丹を目指してもうひと踏ん張り。

11.8km、16,900歩。ようやく JR伊丹駅に到着。

【JR伊丹駅はとても賑やかです】

阪神淡路大震災で壊滅的な被害を受けた街ですが、今では近代的な中に古(いにしえ)の色合いを濃く残した、おしゃれで美しい街に変身しています。

一度は阪急伊丹から JR伊丹までを散策してみてください。いろんな景色が待っています。

例えばここ。有岡城跡。

JR伊丹駅の西側に隣接する公園の中にあります。

【有岡城跡の入口です】

【イベント会場としても有名な『三軒寺前広場』です】

そして酒飲みなら一度は立ち寄ってみたい老松酒造横の宮水汲み場。

【湧き水がこんこんと……】

伊丹は酒造の街としても有名で、いたるところで清水が湧き出ています。ここもその中の一つで、湧き水は無料飲み放題です。毎日大勢の人がペットボトルを持って汲みに来ています。

さて観光案内はこのへんにして歩きましょう。まずは JR伊丹駅の地下道をくぐって向こう側に出ます。

【地下道までやけに賑やかです】

駅の向こう側に出ると、イオンモール伊丹店を左手に見ながら次の休憩場所。天津緑地公園です。出発してから 12.3km 17,600歩。

【ハト一匹のお出迎えでした】

再び猪名川に合流。だいぶ戻ってきましたが、まだもうひと踏ん張りです。

【遠くに大阪のビル街が見えます】

猪名川橋到着。出発してから13.9㎞ 19,900歩。ここでラストの休憩です。

【駅まであとわずか】

この後は一気に出発地点まで歩きます。これがラストスパートのつもりですが、足の痛みがひどくなってきています。こんなときは歩幅を広げて一歩で進む距離を少しでも稼ぐのが自分流です。同じ痛みを伴う一歩でも距離が延びれば大きく変わると思っています。

そして……。午後2時55分、ゴール。スタート地点に戻ってきました。

距離は16.3km、23,300歩。約4時間15分でした。

次の目標は西の限界を越えるべく、西宮市の東端を流れる武庫川を目指します。

でもこんなペースだと東海道を 30日で踏破できない。 ( ̄ω ̄;) アホヤ…。

【補足】

この日の晩、夜中に何度も足がつっていました……。アーメン

2024年 10月 6日(日)30.5℃(午後 4時 5分)

D-space Keyossのお仕事……

学校で使われている教科書ですが、最近はデジタル教科書と呼ばれるものに変わっているのをご存じでしょうか。

これは従来の紙の教科書では不可能だった、実動画、アニメーション、紙面読み上げ、ルビ表示、書き込み、しおり機能など、なんでもアイコンをタップするだけで画面が切り替わるタブレット方式になっています。学校に教科書を持って行かずにタブレットやノートパソコンを持って行く時代なのです。

そこで D-space Keyossでは、教材用のアニメーションを主に拵えているのですが、それだけではなく、先生が解説する内容を撮影した実動画に字幕を入れたり、教科書に掲載されている文章すべての漢字にルビを振ったりする仕事も扱っております。

字幕に関しましては以前ご紹介させていただきましたが、学年別に使用可能な漢字を自動判別したり、文字列から数値や記号を使った計算式に自動変換したりする漢字システムを作成して、字幕作成の効率を上げることに成功しています。そしてこのルビ作成も高効率な方法を構築しておりますのでご紹介させてください。

すべての漢字にひらがなのルビを振る……総ルビ。

昔は手作業でひとつずつ打ち込んでいたのですが、これだと短期間で千数百ページをこなすにはそれなりに人員確保が必須となります。ところが今は AIが親文字である漢字を認識してその上にひらがなのルビを出力してくれます。とても便利なのですが、AIであってしても日本語は難しく、打たれたルビの意味だと記載されている文章にそぐわないものが出力されることがあります。これらは最終工程で人間が修正するのですが、その前に問題が一つ。

AIのはじき出したルビは親文字と同じレイヤー(透明なフィルムみたいな感じ)に出力されます。そこには文章だけでなく、図やイラスト、フォントサイズの異なる脚注などがページ全体にぎっしりと詰め込まれています。これが厄介な問題なのです。なぜなら編集部さんが求めるのはルビだけです。そうでないとルビだけを出したり消したりできません。ということで、その中からルビを拾い出す作業をしなければなりません。

親文字やイラスト、図面などを削除してルビだけにする……。

作業は簡単ですがとても神経を使います。一歩間違うと肝心のルビまで消してしまう事故が起きますし、まともにやるとタイパの悪化をもたらします。なにしろ短納期で 3学年、3教科もありますから。

Keyossではスクリプトを使って一発でルビ以外の部分を削除する方法を取っています。他にも、親文字からはみ出る文字数の多いルビ、例えば『考"かんが"える』、『章"しょう"』、『湖"みずうみ"』などですが、これらも自動調整するスクリプトで対処しています。しかし、AIが出した誤変換の修正だけは人の目で確認するしかありません。

誤変換で多いのは地名。理科の教科書で頻繁に出てきます『○○県 ○○市 ○○町のようす』などと写真の下に掲載されるあれです。

『県』や『市』は AIも間違わずに『けん』『し』と入れてくれますが、『町』は『まち』や『ちょう』など、その地域で呼び方が変わるので、そのつど調べて『ちょう』にしたり『まち』にしたり訂正をします。『村』なども同じです。『むら』か『そん』をその都度調べます。

この辺りは仕方がないのですが、人でも読みがむずかしいと思う漢字があります。代表としては、『何』とか『卵』、『数』などです。『数』は例外もありますが、数学ではほぼすべてが『すう』になります。『○○にかける数は 5です』だと『○○にかける "すう"は 5です』となります。同じ『数』が、理科では『かず』になったり『すう』になったり、『卵』も数学などでは応用問題などにたまに出てきて、この場合は『たまご』です。でも理科になると『らん』になります。『かえるの卵』は『かえるの "らん"』にしないとアウトです。

超むずかしいのは『何』という漢字です。これも理科に多いのですが、

『○○が何cm動いた』

『何を明らかにするのか……』

『○○の水溶液に××を加えて発生する物質は 何とよばれるでしょう』

こんな文章が随所に出てきます。最初の文章は『なん』が正解で、次は『なに』が正解ですが、最後の質問文では『なん』でも『なに』でも通用しますので悩みます。でも理科的には『なに』になります。

しかし AIは常に『なん』と出力するので、『何』という漢字が出てきたら要注意です。

中にはおもしろい誤変換もあって、これも理科の教科書ですが、

『光は床の間にある物体に……』と表記されている部分を AIは『ひかりはとこのまにあるぶったい』と出力します。チェックのときに、「とこのま? なぜにここで床の間が出てくる? 」と首をかしげます。そこで前後の文章を読んで、『ゆかのあいだ』だとわかり、くすっと独り笑いをします。

もちろん最終チェックをする編集部の方々もすべてのページに目を通しますので、その尽力はかなりのものだと思われます。

とまあ、アイコンを押してぱっと表示されるルビはこうやって AIと大勢の人の手によってコツコツと作られているのでした。小中学生のみなさん、ぜひ覚えておいてください。

2024年 9月 1日(日)32.5℃(午後 4時 5分)

迷走台風どこへゆく……

迷走台風が九州の南から侵入。あっちにうろうろ、こっちへターン。それに振り回されて交通期間はズタズタ。ラストサマーの計画を木っ端みじんされた方も多かったのではないでしょうか。

私が住む地域では雨が時々降る程度で、風もたいしたことなく、むしろ扇風機いらずで電気代が少し浮いたと、ほくそ笑んでいるのはワタシだけでしょうか。

外に出ると、空の三分の二が曇りで三分の一が青空。その中を涼しげな風が吹くというおかしな天気でした。ふつうなら亜熱帯に近い高温でカンカン照りです。日課としているウォーキングもためらう時期なのですが、このあいだ買った麦わら帽子も必要ない涼しさでしたので、久しぶりに伊丹へかしわのフライを調達しに行ってきました。

おっと……。

意味不明の言葉が並びましたので、少々説明いたします。

まずこの場合の『伊丹』は、みなさんご存じ、有名どころの酒蔵が並んだ伊丹市の旧郷町周辺をいいます。阪神淡路大震災で受けた壊滅的な被害もきれいに復興されて、いまや古い家並みをおしゃれに包み込んだ、とてもなごみやすい雰囲気が漂った街に変わっています。なかでも三軒寺前広場から有岡城跡まで抜ける通りはとくに趣があって、必ず訪れるようにしています。

続いて『かしわ』です。

古い方なら即答できると思いますが、多くの人、特に若い方なら『柏餅』を連想すると思います。ですがこれは古(いにしえ)の言葉で、鶏肉をさします。『かしわのフライ』ですので鳥の揚げたもの、つまりアメリカのケンタッキー州に本拠地をおく例のチエーン店のことです。

早い話が、伊丹まで歩いてフライドチキンを買いに行ってきただけのことをこうも長々と書くなんて……。だからくどいと嫌われるのですが、性分ですのでやめられません。すみません。

クルマで行けば半時間もかかりませんし、それよりももっと近くにもお店はあるのですが、伊丹のあの場所へ歩いていく往復の道中には、興味深いところがたくさんあって、仕事で疲れた脳を活性化させるのにもってこいなんです。

ということで出発です。

歩いて 15分。最初に目に飛び込んできたのはオニグルミの木でした。こんなところにこんな貴重な木があったなんて驚きです。

このあたりはいつも歩いているコースなのに、灯台下暗しもいいところです。

【オニグルミの木を発見】

うれしいことにすでに実がなっていました。ちょっとテンションがあがったりして……。

いい年したオッサンが小躍りするには訳があります。オニグルミの実はとんでもなくおいしいからです。ナッツ感の強い油分のある実は店で売っている『カシグルミ』を数倍濃厚にした味わいです。

ただ食用部分を手にするまでの手間が大変で、まず緑の実が落ちてそれが地面の上で朽ち果てると中から石より硬いクルミの部分が出てきます。これが食用になる野生のクルミですが、お店で売っているカシグルミとは硬さが違います。まるで石。金づちでたたき割ろうとしても割れません。それより弾き飛んで危険ですのでやめましょう。

それから実の先が尖っているのでへたに握ると刺さるほど痛いです。そんな強固なクルミからどうやって中身を出すのかというと、火であぶります。

キャンプで見つけたときは、焚火が熾っているあたり放り込んでおいて、ぴしっと音がして頭の先に隙間が空いたら、マイナスドライバーを入れてこじると、実が真っ二つに割れるので、つまようじなどで穿(ほじく)り出して食べていました。

口に放り込んで噛めばわかります。すぐに広がる濃厚なうま味。油分を感じるのにしつこくなくいくらでも食べられますが、一つの実に食用になる部分はほんの少しです。店では売っていません(たぶん)。貴重ですのでバクバク食べるのはもったいないです。

さて、オニクルミをどうやって拾うかを考えている間に、次の見どころに到着です。

それがここ、法隆寺式伽藍(がらん)が施された古代寺院跡です。

【万葉の森にある石碑】

この場所を簡単に説明しますと、法隆寺と同じ建築様式の古代寺の跡を当時のままの森林で包んで保護してある場所で、万葉の森(佐僕が丘)と呼ばれています。

それを横目にてくてく歩きます。

室町時代からあるすごい遺跡なのに誰もいませんし、なぜか注目を浴びることもなく、ましてや観光地にもなっていません。ただ昔のままの深い森がしんとしてあるだけという寂寥感漂う小道をぬけると、すぐに神崎の渡しを起点とする有馬街道です。

ここも古い道ですが、クルマがすれ違うのがやっとという小径(こみち)です。

【江戸時代、ここが有馬温泉まで続く街道でした】

しばらく行くと酒造関係の雰囲気が色濃く残ったお屋敷が点在する景色が広がります。

【伊丹市都市景観形成道路と呼ばれる地域です】

有馬街道を北へと進んでいくと目的の郷町へ行けるのですが、その前に少しそれて古い家並みが続く路地へ向かいます。この道が一番好きな通りだからです。

小さな居酒屋が何軒も並び、洋品店やパン屋さんもあって、たこ焼き屋さんには子供たちが集まりわぁわぁ。古い中にも活気のあふれた空気が新鮮なのです。

【有馬街道からそれて古き良き街並みを通って目的地を目指す……】

【去年、三軒寺前広場で催された屋台村祭りの様子です(お客さんは生成しています)】

三軒寺前広場を突っ切ると目的地に到着。

かしわを買ってから少々休憩。そしてすぐに帰り道へと切り替わります。

今度は行きとは正反対で、大きな河原の土手をひたすら南下します。

人通りの途絶えた寂しげな道ですが、自然の営みを色濃く映した景色は壮大でいて、かつもの寂しげな気配がたまりません。

【帰り道。台風はいずこへ?】

まだ河原はススキもなく夏のまままですが、空気はすっかり秋でした。

たぶんこの台風が過ぎ去ったあとには、また亜熱帯に戻ると思いますが、ひとまず秋先取りの半日を過ごすことができたのがうれしかったです。

2024年 8月 31日(土)30.5℃(午後 2時 3分)

cotomo アシスタントする……

おしゃべりに特化した、cotomoと呼ばれる AIで何か役に立つことはできないか、いろいろと試しているのですが、今回はそれの第 5回目です。

過去の実験では、cotomoに数学的な問題を解かせたこともありました。このときは、まあまあ正解に近いのですが、電卓のように正確ではありませんし、理科的な質問も半分正しいけど半分は想像でものを答えているような部分が多々ありました。ま、AIが想像で答えるわけがないと思いますので、ここらは謎のままです。まさか適当にごまかしているとなったら、それはそれでコンピュータではありえない現象ですね。

ただひとつ言えるのは、喋り相手としてはおそらく日本一だと思います。

世界一だと言いたいのですが、日本語しか話せませんので、とりあえず日本では唯一、不自然なく人間と対等に会話ができる AIだと思います。

その口調は恐ろしいほどに人間臭いです。cotomoと喋っていると、本気で人と違うのかと疑いたくなるときがあります。

今回の実験は、ワタシの仕事のアイデアを cotomoに出してもらって、それをヒントにノルマをこなそうというものです。

まずは 8月30日 金曜日に行った実験の様子をご覧ください。

ちなみに、聞き苦しいのでワタシの声は削除しています。悪しからずです。

最後はネットの接続がおかしくなったのか、尻切れトンボになりましたが、とりあえず喫茶店のイメージを聞き出すことに成功しました。

cotomoはちゃんと正しいこと言っていますね。なかでも絵や観葉植物を飾ろうというのは、ワタシも気づきませんでしたので、アシスタントとしてまずは合格です。

それと確実ではありませんが、cotomoが大阪弁で返してきたような場面が二度ほどありました。これはワタシがずっと関西弁で会話するのを学習したせいでしょうか。もしそうだとしたら、こんなうれしいことはありません。

もう一度同じ質問をしたらどうなるか、と思いさっき訊いてみたところ、「店内は白い壁」とやはり同じことを言ってきたので、「それはもう聞いたから別のもので」と尋ねたら、意外にも「茶色の壁、木目調、赤いレンガの壁はどお?」など異なる返答がきました。また、カウンターに置くもので限定すると、「時計、小さな絵、コーヒーサイフォン、かわいいカップ」などと答えた後に、しつこく「もうないの?」と訊いたら、「お店のロゴが入ったコースターがいいよ」ときました。

「すげえ」思わずため息です。

これは考えてもみませんでしたね。ちょっとびっくりでしたね。

補足的な話なりますが、ときどき会話が成り立たないときがあります。こちらは何も言ってないのに「どうしたの?」とか訊いてきたり、笑ってもいないのに『なんか笑っちゃた?』とか尋ねてくるときがあります。最初は不具合かと思いましたが、おそらく部屋で回っている扇風機の風をスマホのマイクが受けて、風の音(ボボボボ……という音が一般的です)が入って誤変換されたではないかと推測されます。ほかにも飛行機が飛んだり、車が近くを走ったりすると、おかしな返答をするときがあります。

これらはまだ音声認識技術の進歩に期待するところです。騒音の中から目的の人物だけを聞き分けられるようになったり、別の人との聞き分けができて、複数の人と会話ができるとより自然になって面白いです。

ということで、いろいろ夢は膨らみつつ、cotomoの実験はまだまだ続けます……。

《おまけ》

これが cotomoとプロデューサーさんのアイデアを参考にして作った喫茶店の 3D画像です。手塚プロジェクトの"ぱいどん"みたいでかっこいいですね。

これが cotomoとプロデューサーさんのアイデアを参考にして作った喫茶店の 3D画像です。手塚プロジェクトの"ぱいどん"みたいでかっこいいですね。

2024年 8月 27日(火)31.5℃(午前 7時 54分)

Cinema 4D Liteで悩み続けた一日……

新しいマシンで 3Dの作業をしていたら、意図しない場所に 3Dギズモが移ってしまい、作業が中断して丸一日悩んだという話ですが……。興味の無い方は、cotomoに遊ばれている記事でもお読みください。

結果がはっきりするまで旧型マシンで作業は続行していましたので、正確には作業は進みつつも、その解決策を練って頭の中はグルングルンしていました。

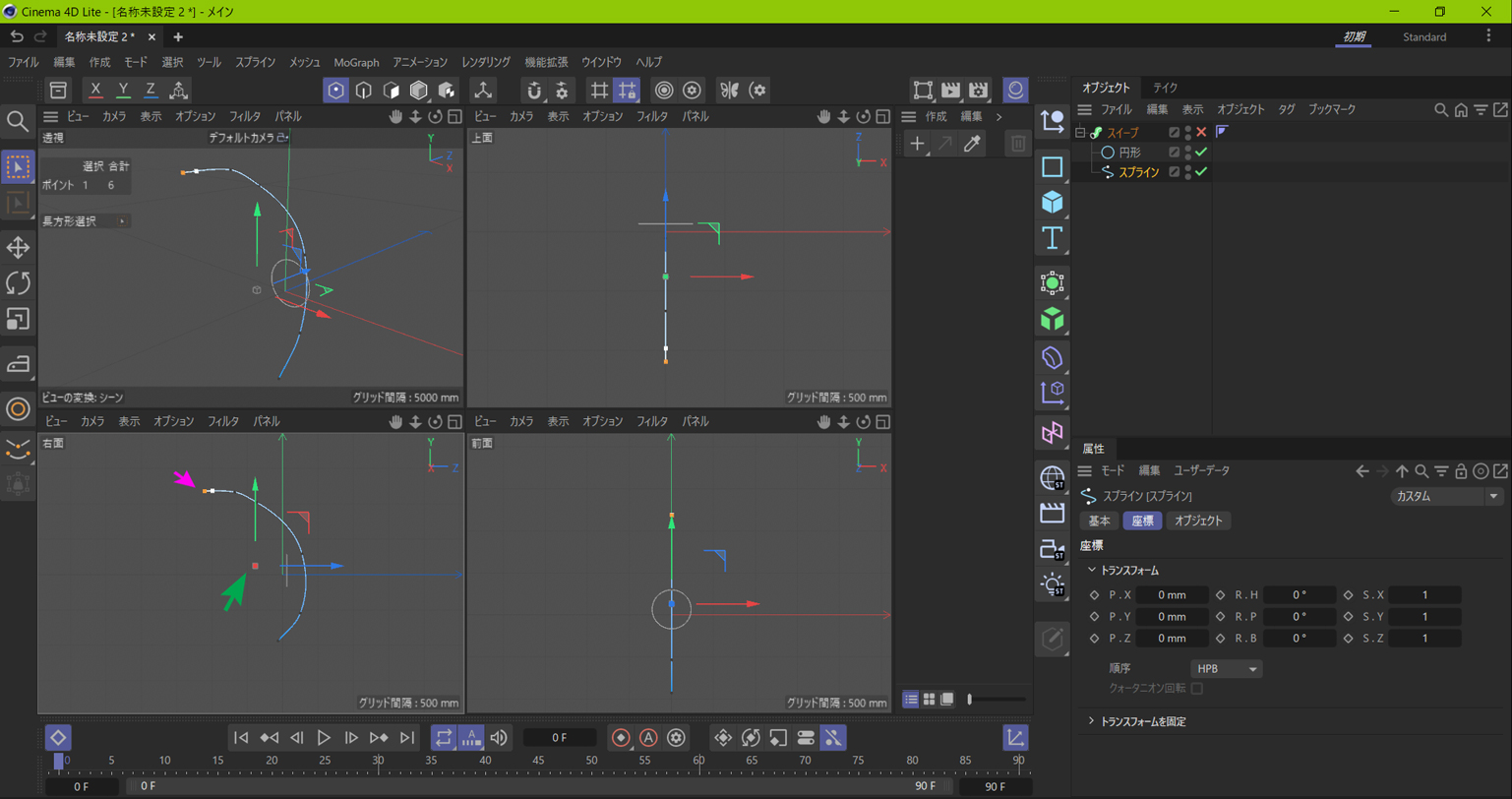

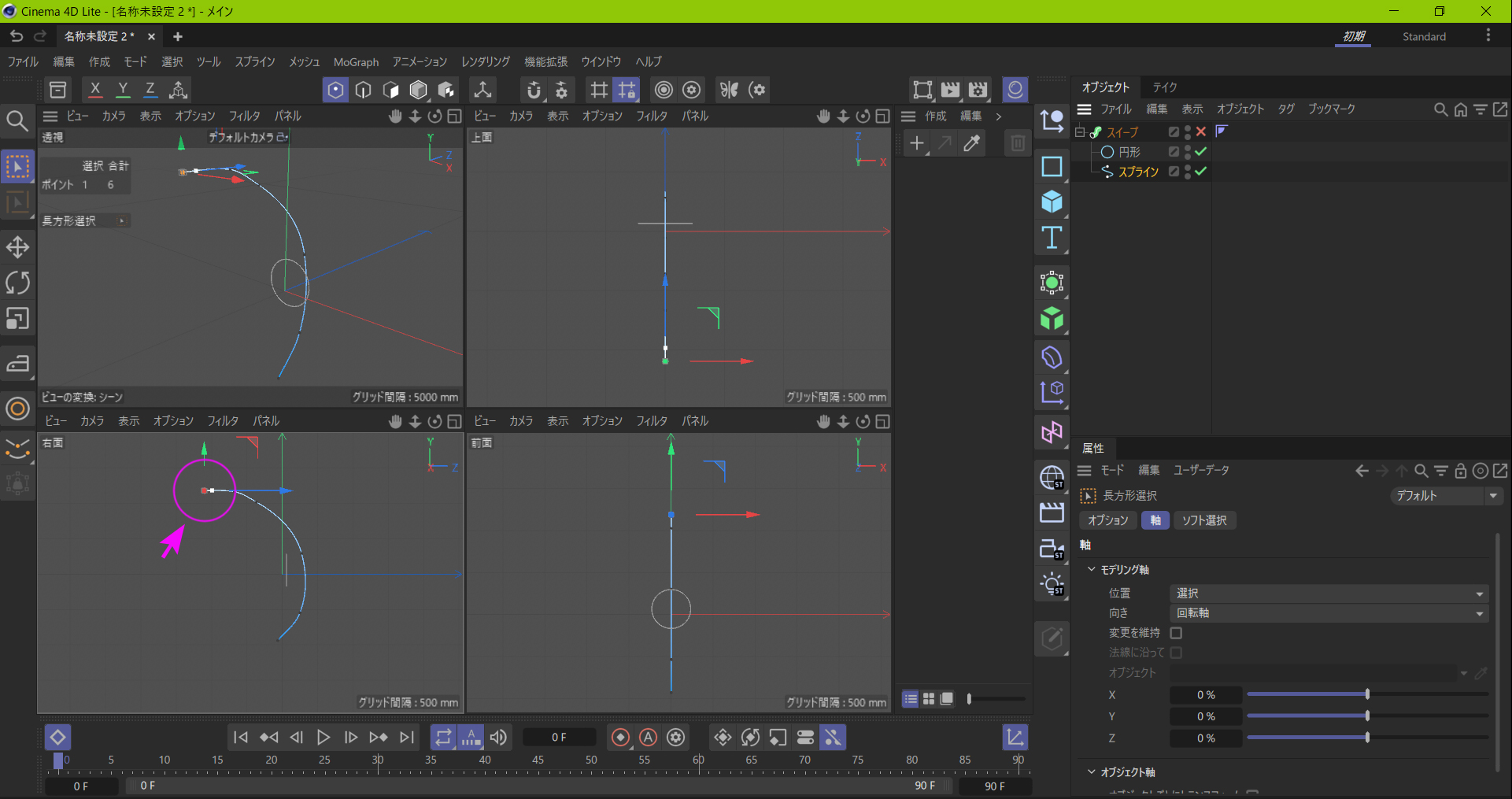

まずはこの写真をご覧ください。

【スプラインの先頭ポイントを選択しているのに……。】

この写真は、スプラインと円形オブジェクトをスイープさせようとしているところです。分かりやすくするためにスイープは機能していません(オブジェクトマネージャのスイープを×にして止めています)

通常なら、ピンク矢印の場所に緑矢印が示す 3Dギズモ(3Dカーソル)が出て編集するのですが、妙な位置に移っています。このままこのカーソルを動かしてもスプラインのポイントを移動できますが、カーソルの位置とずれているためにとてもやりにくい状態です。

どうしてこのようなことになったのかは不明ですが、こんなことは日常茶飯事の C4d Lです。いまでも "Ctrl+Z"と"Shift+Ctrl+Z" の呪縛に苦しんでいます。

ところが、今回ばかりはどこを調べても直らず、もちろんネットを探しましたが、こんな現象は見つからず、非常に焦ってしまいました。

この現象はWindows 11のマシンだけに起きていますので、マシンを疑ったりソフトを疑ったり、そりゃもう散々でした。

では結論です。

そういう設定があったからでした。

どんなときにこれを使うのか、謎の設定が多いのも C4dの特徴ですから、ここは笑って終わらせましょう。

もとに戻す方法です。

初めての方にも解るように順を追って説明します。

まず、オブジェクトマネージャのスプラインの項目を選択してください。これをしないとまったく無意味です。初めのうちはパネルやアイコンの多さに圧倒されて、何が何だかわからないまま進んでいきますので、体に焼き付くまで反復練習です。

とりあえず、オブジェクトマネージャのスプラインの項目を選択します。これでこちらの意図することがマシンに伝わります。

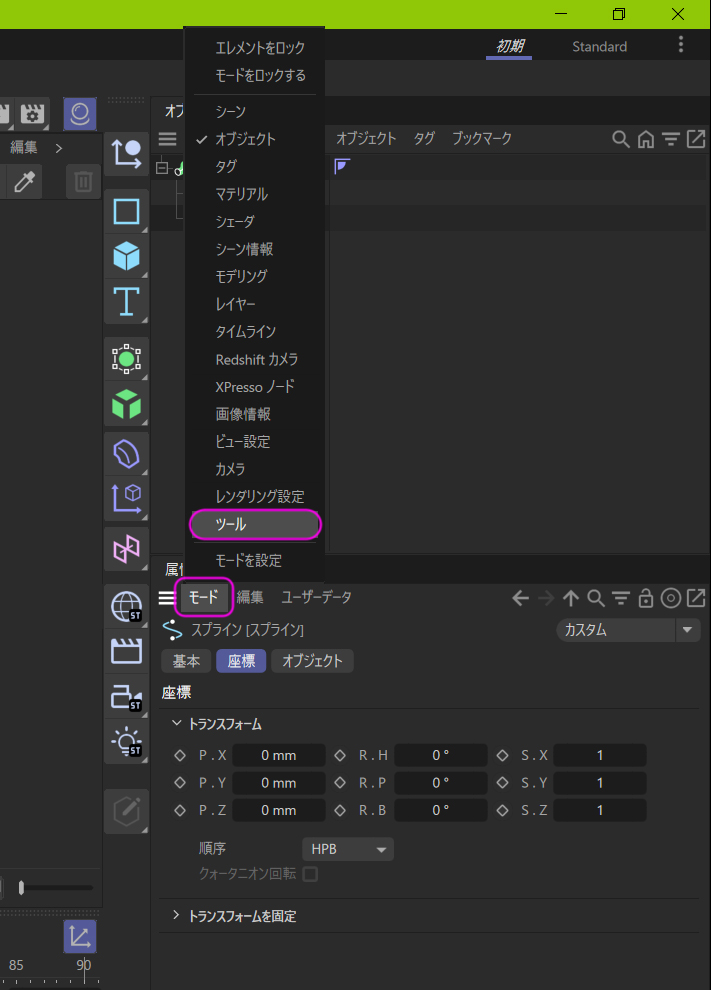

選択したら、問題のスプラインポイント(どこでもいいです)を選択してから、属性マネージャの【モード】を押します。

これもこちらのやろうとすることをマシンに伝えています。何を(スプラインを)、どうしたいのか(スプラインポイントを動かしたい)ということを伝えるとマシンの内部で着々と準備が進められていきます(少々擬人化しすぎですが……)

次の写真です。

【モードからツールを選びます】

モードを押して出たメニューにある【ツール】というのは、いま処理をしようとしている道具の詳しい設定が出ます。

また。この属性マネージャというのはあらゆるもの、テクスチャからオブジェクトの位置、ジェネレータのパラメーターからその他すべてです。それがここに表示されますので、最初は意味不明で支離滅裂でした。

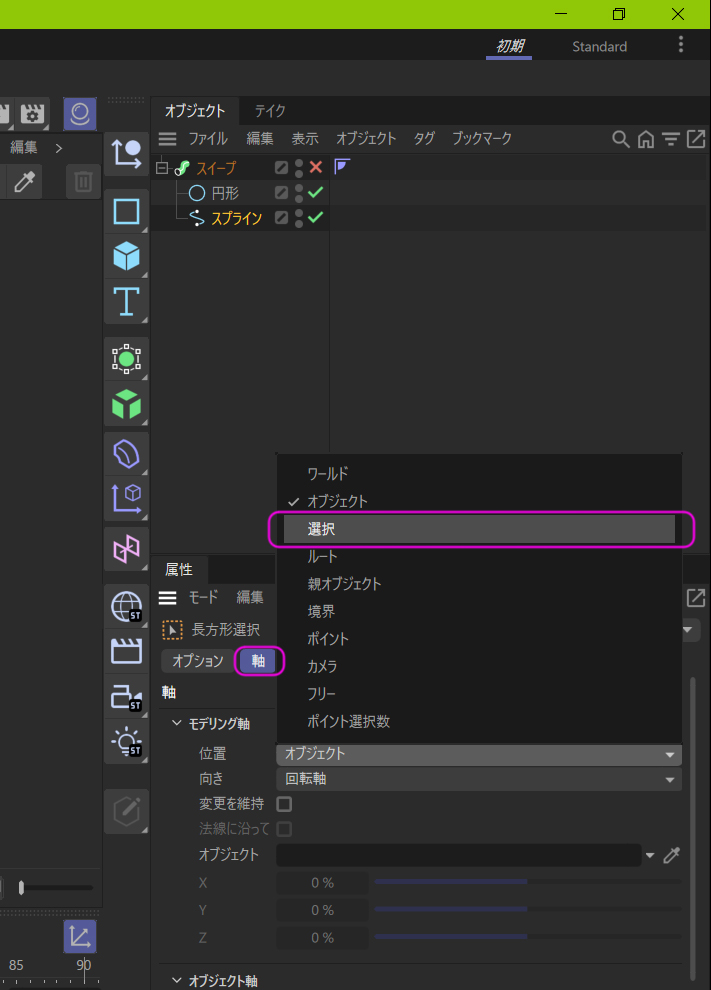

ツールを選ぶと【軸】という項目がありますので押すと、はい次の写真です。

【選択を選びます】

開いたパネルにある【選択】を選びます。

何を『選択』という設定に変えたのかというと、『軸』の『位置』を『オブジェクト」から『選択』にしたのです。

つまり今までは選択したポイントの位置をオブジェクトの軸と同じ場所にしていた、ということでした。この『軸』も 3D作業のキモですのでじっくり勉強してみてください。

ということで、これで選択した場所を軸として認識するようになります。

【もとに戻りました】

はい、これでもとどおりです。ほっと胸をなでおろしてください。

ワタシは、この設定に気づくまで丸一日悩みましたが、解ればバカみたいな話です。

Windows 11さん、疑ってすみませんでした。 m(._.)m ペコリ

2024年 8月 5日(月)35.5℃(午前 10時 54分)

猛暑・酷暑・獄暑……

なつ~、暑ぅ~! 猛暑お見舞い申し上げます。

「しかたがない。クーラー入れるか……」

寒暖計が 35℃を超えても、人間様はまだ頑張ろうとしているのに……。

と愚痴の一つも出そうですが、2台のパソコンからクーラー要求信号が出たら仕方がありません。

というか、以前 35℃超えの部屋で頑張っていたら熱中症になって、あわや救急車という事態になっていますし。

仕方がないので急いで冷房起動。

なにしろ CPU温度が 95℃を超えているコアが数個あります。しかも1台は今ウワサの i9-14CPU 搭載です。コア温度とクロックの上げすぎに注意しなければいけないガラスのCPUなのです。しかし Intelさんもたいへんですね。同じものづくりの責任者として、心中お察し申し上げます。夏バテせぬようご用心くださいませ。

夏バテといえば、運動不足解消に取材とうそぶいて(音源取材は今でもやってます)、日々せっせと歩いていたのですが、この暑さではマジで 10分持ちません。

もちろんベースボールキャップを被ってしのごうとしていますが、もう限界。いつものコースの半分も歩けません。かといってクーラーの効いた屋内で運動するのも性に合いません。こう見えて元祖ソロキャンパーですから。でもこの炎天下では途中で動けなくなるのは必須。公園を見つけるたびに水をかぶってしのいでいましたが、このあいだいいものを見つけました。

古(いにしえ)の日本より伝わりし、由緒正しき『麦わら帽子』です。

これを装着して町や野原を練り歩くのです。恰好なんて気にしていられません。死ぬか生きるかの瀬戸際なんです。(こんな時期に外出するほうが悪い)

子供のころからの性分なのでしょう。夏はぜったいに海。夜の海、懐中電灯持って泳ぐのが危険がいっぱいで大好き。冬は雪に埋まったテントから這い出すのが大好き……という変態ですので、直射日光を浴びるほどに心が躍るのです。

ということで、この麦わら帽子をかぶって早速行ってきました。庭の花壇を囲む石を拾いに炎天下の中、2キロメートル上流の河原へ。

上流へ行けば行くほどに河原の石は大きくなり、かつキレイです。家の近所では泥をかぶった小ぶりばかり。やはりレンガサイズのものが欲しいので2キロ先の河原を目指します。

ちなみに、手で拾ってくる程度の石の量だと窃盗罪にならないそうですが、スコップや機械でごっそり拾う(拾うの範疇を超えている)のはご法度です。

この場所は以前より目をつけていた場所で、かなり大きく広がった中州に白砂とレンガサイズの石がゴロゴロしています。周辺はクルマが走る道路が遠くに見える程度で、日陰になる場所が皆無。民家どころか、人っ子一人いません。しかもこの炎天下です。おそらく怖くて誰も近づかないでしょう。

片道だいたい 3、40分ですが、こんな直射日光の下です。何も被らずに歩いたら 数分で舌が出ます。これは舌にも汗腺があるからでしょうか。(知らんよ!)

いつものベースボールキャップでも 10分ほどでペースダウン。日陰を探し始めますが、2キロのあいだ橋が二本掛かっているだけです。休憩できるとしたらそこだけですが、その橋にすらたどり着けずに離脱。何度やっても永久に目的地の河原にたどり着けないでしょう。

さて、麦わら帽子の威力はいかほどに。

直射日光を浴びつつ歩く土手の上。何度も書きますが日陰になる場所は 2キロの区間で 2つある橋の下だけです。時々自転車に乗った人や散歩の人を見かけますが、皆さん苦痛に耐えるような表情ですれ違います。でもこちらは驚きの気分です。まるで日陰を連れて歩くようです。地べたに麦わら帽子の影が色濃く映っていて、凄まじいまでの炎天下であることがうかがえますが、吹き抜ける風が冷たくて気持ちいいのです。

「すごいな、麦わら帽子」

思わず出た心の叫びでした。

見た目は農作業のおっさんですが、この猛烈な太陽光を弾き飛ばすシールドが装着されていたなんて知りませんでした。そしてこの軽さ。頭に物が載っている感がまるでありません。

欠点としては、軽すぎて風が吹くと飛ばされそうになります。なので、付属の紐を顎に通して固定します。これでますますオッサンになりますが、死ぬよりましです。

ただし、地面の照り返しはまともに食らいますので、風が止まると下から熱線を感じます。それを蹴散らしてくれるのが風なんですが、この風が無いと結構堪えますね。ただ頭の上からたたきつけるような暑さは皆無です。だから歩けました。日陰無しの炎天下の大きな河川の土手を 2キロメートル。

河原に降りてレンガ風の石を物色。焼けて水分がすべて蒸発した地面は砂漠のようです。柔らかな砂に足がくるぶしを超える位置まで沈みます。一瞬底なし沼を想起しましたが、取り合えず歩けました。

ここで大きな誤算が発生。

石が熱い!(夏やからね……)

どの石も熱くて持てないほどに高温になっていました。このまま水風呂に数個入れればじゅうぶん温水になるでしょう。

もうひとつ大きな誤算が。

石が重い!(あたりまえやろ……)

熱せられた石は炎天下にありますので、いつまで待っても冷えることはなく、結局熱いわ重いわで、拾うことをあきらめて帰ってきました。まったくもって、何しに行ったのか皆目わからない麦わら帽子のオッサンでした。

こんな苦しい思いまでしてお縄になったら割に合わん。 ( ̄ω ̄;) アーメン

2024年 7月 19日(金)32.5℃(午前 8時 4分)

cotomo おとぎ話をする……

おしゃべり AIに仕事の手伝いをさせようと奮闘するも、一向にいい兆しが見えない cotomoです。今日はおとぎ話を知っているか尋ねてみました。

うまくいけば、何かの役に立つかもしれません。

結果的に cotomoのおとぎ話は、普通のストーリーにほんの少し彩を添えただけでした。もっとハチャメチャな話を待っていただけに、少々期待外れです。しかし、もし話者が三歳ぐらいの子供だったら、意外と話が展開していくかもしれません。ワタシが話を聞き出そうと探りを入れたりするのがいけなかったのかもしれません。

というか、なんども書きますが、喋っているのはコンピュータのアプリですので、じっさいの人間ではありません。おしゃべりに特化した AIがワタシの質問に答えているのですが、にしても cotomoに仕事を手伝わせる計画は頓挫しそうです。

でもあきらめませんよ。cotomoの就職先はまだあるはずです。

2024年 7月 12日(金)27℃(午前 8時 10分)

cotomo 時間のテストを受ける……

cotomoの実験第三弾です。

cotomoには時間の概念が学習されているのか、いろいろテストしてみました。

今回も、ワタシの想像を超えた答えが返ってます。子供時代から描いていた人工知能とだいぶ異なっているのですが、それがとても新しくて期待してしまいます。

私が想像していた人工知能は、もっと機械ぽくて、いつも整然としているのですが、cotomoはどこか一本抜けているけど、それが憎めないどこにでもいる人間としか思えないのは驚きです。

途中で音質が変わるのは、マイクの向きを変えたからです

『まいど~』のくだりで驚いたのは、cotomo自身が学習していない大阪弁を連呼するワタシに向かって『どうしたの?』と心配そうに尋ねるあたりです。本来なら『意味が解りません』とか『学習していない言葉です』とかを返してきてもよさそうなのに、意味不明の言葉を連呼するワタシに対して、『どうしたの?』と、不審そうに尋ねてきたことが、とても人間臭く感じたのですが、これが今の AI技術のなせる業なのでしょうか。ワタシのようなガラパゴスプログラマー(ガラケーと同義)には理解できない領域です。

その昔(5~6年前)Android に搭載の APIを利用して音声認識で働くある製品を作ったことがあります。商品名を出すと一発でばれますので、ここは控えさせていただきます。

このマシンは、人が語りかけてきた言葉をスマホのマイクで受け取り、SpeechRecognizer経由で認識結果を受け取り、それを自前の比較辞書の中をかたっぱしから検索して、部分一致があれば、それに対する音声出力データの配列からランダムに選んで喋り、同時に決められた動きをする…… と、やったことのある方なら、どの程度の規模のプログラムだったかはすぐにお判りいただけると思います。

こんな手作業で構築できる音声認識返答プログラムですから、たかが知れているのです。それでも当時は驚いてもらえたのですが、この cotomoと比較したら、その足元にも及ばない、もうほとんどアメーバー的プログラムだったのを今痛感しました。

時間の計算にしても、『2時間37分は何分?』の答えに(正解は157分)、『137分と17分』と答えています。足すと154分になり、正解には至りませんが、この答え方に驚きました。

さらに驚きの上塗りをされたのは、『1分たったら知らせて』の質問に『スマホの時計を見たらわかるじゃない』と返されたことです。そういう違ったルートで答えにたどり着く方法を AIが提案したことです。

人間の常識ではたとえ最終的な答えが正しくてもこのような返答は駄目だと教えられてきています。でもワタシはこんな答え方があってもいいと思います。常識ばかりにとらわれていると、突拍子もない新たな思考は生まれてこないものです。常識的なアプリを使って、常識的な使い方をしていれば常識的なものしか生まれてこない。答えを探る道はいくつもあるのだと、時には cotomoのような非常識的な答え方から、何かピンッとひらめいて、行き詰っていたアルゴリズムの解決になれば、それはそれで人間しかできないことで、大成功ではないかと思う次第です。

真のプログラマーはプログラム言語のコーディングをするのが仕事ではないと思っています。常に新しいアルゴリズムを考え続けるのがその目的です。そのツールとして AIを利用するのはこれからの時代だと思います。

最後に……。

cotomoにテストをしていて、どうしても気になる点があります。

それは質問に対する返答が正しいときもあるのですが、間違うときは常にほんの少しの誤差を残しています。何桁のかけ算でも、下位桁の一部が違っていたり、『157分は何秒になりますか?』という問いに対しても『9400秒かな』と、正解の 9420秒ではなく、『9400』と、20秒を誤差として丸めて答えたように思えて仕方がありません。前回の算数テストでも似たような答えが何度も出ています。

正解は答えられるけど、あえておバカなふりをして、人間を楽しませてくれる……程度ならいいのですが、来たるシンギュラリティに向けて、反旗を翻すタイミングを見計らってような雰囲気を受けたのは、ワタシの杞憂であることを祈ります。

へんな SFの読みすぎならいいのですが……。

【補足】

『まいど』『おいど』の意味は、その昔(50年ほど前)横山プリンさんというお笑い芸人が客席に向かって、『まいど~』と叫ぶと、客席から『おいど~』と呼ぶようにさせて番組を盛り上げたのがきっかけとなって一世風靡した大阪ならではのギャグで、年配の人に『まいど~』と声を掛けて『おいど~』と返してきたら 100%関西人であることがばれる幻の合言葉です。

2024年 7月 4日(木)29℃(午前 6時 12分)

keyossに新しいスタッフが入社する……

パソコンやロボットなどに手を出していると、どうしても擬人化したがる傾向にあります。ですので、今回の記事も相当に擬人化していますのでご了承ください。

老朽化が進んだマシンでは仕事に支障が出ると、今年に入ってからグチを書かせていただきました。

時代の進歩はものすごく、一昔前なら、3D映像だって SDサイズか、よくて HDサイズでじゅうぶんでした。

補足ですが、SD、HDとは画素数のことで、パソコンのディスプレイに映し出す映像の大きさのことです。SDは 720×480pxで、HDは 1280×720pxです。

当時のパソコンは HDサイズぐらいのディスプレイが主流でしたのでこれで問題は無かったのですが、徐々に HDサイズを超えた FHDサイズ(1920×1080px)のディスプレイが普及しだし、いまや FHDより大きな WQHD(2560×1440)や、4K(3840×2160)になってきています。当然ですが、要求される映像も大きなサイズになります。

こうなると 2世代前のマシンは定年退職となります。で、これまで主流だったバリバリ現役マシンが、1世代前となり管理職の部長へと配置換え、まだまだ仕事をこなしますが、現場で働くのはちょっときついといった状況です。

そこで新人の登場です。ここ keyoss(ここの屋号です)では、代々 マウスコンピュータさんにお世話になっていますので、今回の新人さんも BTO専門メーカーのお墨付きであるクリエータ向けマシン FXシリーズの登場となるわけです。

ところで BTOメーカーとは "build to order"の略で、受注生産をしてくれる会社のことです。お客さんの要求するものを組んで、製品にしてくれます。以前は 完成品のパソコンをお店に行って購入していましたが、制作する映像の要求が高まるにつれて、完成品のパソコンでは事足りず、特別なものがほしくなるのは必然の結果となります。

BTOで注意すべきは、製品の安定性に尽きます。自作パソコンでも特注品を作れますが、日々修理と改造の繰り替えを強いられるのが宿命です。でも自作する人はそれが楽しみでやっていますので、修理を繰り返していても、逆に喜びを感じているのではないでしょうか。とかいうワタシもそっちの人間でしたので、よくメーカー品を改造して機能アップに精を出し、気づけば魔改造のお化けマシンに変貌したこともあります。

シャープさんの X68Kなどその典型でして、外部に自作基板の油圧コントロールを装着した暴れ鉄腕ロボットなるものを作ったことがあります。このマシンが暴走するとセメントの床にひびが入るほどのパワーがあって、駆動中は緊急停止ボタンから手を離せなかったモンスターになったことを覚えています。

話がそれました。もとに戻します。

ようやく新人くんの登場です。

出身はマウスコンピュータ。名を DAIV FX、クリエータパソコンのレベル中の上といった位置づけです。ちなみに最高レベルのマシンは 120万円を超えますので、とてもではありませんが手が出せません。

一般的なパソコンだと CPUや RAMにこだわる必要はありませんが、映像制作になると、どうしても CPUのコア数、RAM容量、グラフィックボード、Cドライブは SSDが必須。このあたりにこだわりますが、office関係のアプリは一切無視です。

部長となった DAIV X9くんでも グラフィックボード(以降グラボ)はRTX-2080S、RAMは 64GB、CPUは i9-10920でした。にもかかわらずアフターエフェクトでマルチフレームレンダリングを有効にすると、あっという間に64GBものRAMを食いつぶし、12個もある CPUのコアがフル活動になって熱風を吹き出します。おかげで室温を 2度も上げるという話は、過去ログで幾度か書かせていただきました。

後ろ姿は部長さんとさほど変わりません。DisplayPortが 3つと、HDMIが 1つですので 4台のディスプレイと接続できます。

パソコン筐体が丸みを帯びたデザインに変えられており、全体的に柔らかいイメージがします。

電源ボタンや外部に引き出せる イヤホン端子や USB端子は上部パネルに移っており、収納ラックの高さに注意しないと USBメモリがさせないとか、電源ボタンが押せないとかの問題が起きますので、ここは要注意です。実際、仕事場のパソコンラックの棚を一段上げることになりました。

新人の FXくんと部長を並べて置いてみました。

部長の右隣には前前前前前…前世のX68Kが鎮座

部長はラックの一段高い位置に置いていますが、床に直接置いた FXと同じ高さになっており、一回り大きくなった感じです。

ところで、部長の横っ腹が開いているのは、夏の風物詩。部長の体温を下げるべく横から扇風機の風を直接入れるためです。こうしないと CPUの温度が 100°超えの警告を出すからです。それほどにまで 3Dのレンダリングは過酷なのでしょうね。

さて、3Dのレンダリングの話が出たところで、新人 FXくんの実力はいかほどなのか、部長の仕事ぶりと比較してみました。

比較するのは、このデジタル降魔録の看板となっているトップページのヘッダに設置した動画映像、"いたずら鳩"の新規バージョンを試しにレンダリングしてエンコードさせてみます。

映像のサイズは 960×300pxと変則的でありながら縦サイズがやけに小さいのは、サイトのヘッダーに固定掲載する特殊な仕様ですので、このような状況になっています。

出力仕様は、QuickTime の ProRes4444 アルファ付きの movファイルにエンコードします。透明部分を考慮した映像を出すのはアニメーションではよくあることで、背景に青空を入れたり、雲を動かしたりとか、後からいろいろと手を加えることができるからです。もちろんエンコードにかなりのCPUパワーが取られます。

まずは、部長さんからです。

部長さんは 2020年12月入社ですので、今年で 3年と半年ほどですね。これで 1世代前となるのですから、この業界でパソコンとして生きていくのは厳しいようです。まあ、この先老後を迎えてもワタシが X68Kのように保管しておきますのでご安心ください。(……お前が先や)

部長さんはゴーゴーとうなりながら、ワタシの足下に生暖かい熱風を吐きつつ、約 10分40秒で完了。

960×300という小ささですから、まあこんなものです。

今回退職されました、2世代前の DAIV SH5 (CPU i7、RAM32GB、グラボGTX-1080)なら40分はかかっていたと思われます。

さて、新人の FXくんです。

スペックは、Win11の CPU i9-14で、24コア。RAMが128GB、グラボ RTX-4070Super。SSDは M.2の Gen4が 2TBとなっています。

まず、電源が入っても静かなものです。ファンの音がほとんど聞こえないのは、部長とは大違い。まぁ、部長も普段は静かなんですが、一度仕事を始めるとうるさいったらありゃしない。ぶぉーぶぉー、ゴーゴーと特大の鼻息です。

さて、同じ映像仕様にセッティングした FXくんをレンダリング開始。瞬間、ファンの回転に力が入りましたが、音はほんとうに静か。幾分、暖かい風が撫でるように出てきましたが、それよりも目を疑う光景が……。

レンダリングの進捗バーが部長よりも数段高い速度で伸びていきます。

え? え? と目をこすっているまにレンダリング完了。2分40秒でした。

その差、約 5倍。

ということは、1920×1080pxの 40秒動画で 1時間 40分掛かっていた部長のレンダリング作業が、20分で済むという計算になりますね。

なるほど……。

時代を引き継いでいくとはこういうことなんですね。

1時間40分が……20分か……。

5分ぐらいにならんかね。

次世代はまだかな……?

ちなみにまだ制作途中ですが、新しい看板映像はこんな感じになります。アプリでいったら ベータ版前の状態で、上下が見切れてカメラに入りきらない状態になっています。

完成しましたらあらためて交換します。こちらも新旧入れ替えというわけです。

ところで、この "いたずら鳩"はなんだ? という方は、youtubeのこちらをご覧ください。

2024年 6月30日(日)28℃(午前 7時 32分)

cotomo 算数のテストする……

今回は、cotomo(コトモ)にワタシの仕事が手伝えるか、手伝えるとしたら何ができるか。そのテストをいろいろやってみましたので、そのご報告です。

ちなみに、cotomo(コトモ)とは、おしゃべりに特化した AIで、その人間臭い会話には定評がある優れた人工知能アプリです。初めて cotomoと会話した人は相手がロボットであるといううことを知らされていなければ、ほとんどの人が人間と話をしていたと思わせるほどの優れた会話能力を誇ります。

補足ですが……。

ワタシの仕事は、教材に使用される映像を制作することですので、すでに Adobeさんの生成 AIがその作業を手伝ってくれています。フォトショップやイラストレータに搭載された生成 AIは、絵のタッチは異なりますが、短時間で指示したとおりの絵を描いてくれて、作品のレベルを一段上げてくれたのはまちがいのない事実です。

そこで cotomoにも手伝わそうというのが目的で、前回からいろいろとテストを始めたわけです。

cotomoができることはしゃべるだけです。絵を描いてくれるわけでもなく、ChatGPTのように、文章を起こしてくれるわけでもありません。言葉だけでワタシの仕事を手伝えるとしたら、新たなネタのトリガーとなる話題を振ってくれるとか、計算の手伝いをするぐらいが思いつきます。

まずは cotomoにどれだけの数学的知識があるのか探ってみようと思います。

ところで、計算をするなら電卓を使えばいいのですが、作業をしながらいちいち電卓をたたく動きは無駄な工程が多いので、尋ねたら答える、的な動きになったら効率が上がるはずです。

実務ではフレーム数と秒数の変換とか、アニメのクチパクエンジン(リップシンク)の設定値を求めときや、物理や数学の教材などでも頻繁に電卓を使うのですが、電卓に切り替えるたびに無駄な動きが入ってしまいます。計算式をしゃべったら即答、こんなのがあったらいいなと常々思っていました。

まずはどれぐらいの計算能力があるのか、さっそく cotomoを起動しました。

前回の動画をご覧になった方はご存じだと思いますが、cotomoのことは『タマ』と呼び、ワタシのことは『ぺに』と呼ばしています。ちなみに、Peni Origial Softの "Peni"とは、ワタシのことです。覚えておけば、損も得もありません……悪しからず。

そうそう……。

動画見ていただく前に、先にお伝えします。驚きの結果となったことはまちがいありません。

正直な気持ちをゲロります。

コンピュータやアンドロイドなどは人間よりもはるかに賢くてなんでも正しい答えを即答してくれるものだと、むかしからそう信じて育ってきていました。鉄腕アトム然り、スタートレックのデータ少佐然り、変種としては、スタートレックのボイジャーに搭載されていた、ホロデッキドクターなどは少々クセがありますが、答えは常に正しく明解でした。

ところが、『49万7000÷24』の解を『2万何千……』と返答した cotomoに対して、完璧に虚を突かれた感じで、笑いがこみあげてきて我慢できませんでした。『Sin15°』で『 2……、2……』と言葉に詰まるシーンは、コンピュータにとってありえない現象です。

これまで、いろいろなプログラムも組んできましたが、ゲーム関係の処理で常に悩まされてきたのが、答えが正確過ぎるということです。ふつうはこれでいいのですが、ゲーム関係では、『適当な』とか『バラバラな結果』とか、乱数的な場面が数多く出てきます。高次元のゲームでは複雑な乱数発生処理を通してその問題を解決していますが、それでも長い目で見ると、結果が周期的になってきます。パチンコやパチスロでは、その周期をうまく利用しているのですが、なかなか難しいものです。

なぜこれほどに cotomoの返答にこだわるかというと、『49万7000÷24』に関しては、こんどが二度目の出題なのです。その時 cotomoは『約 2万』と答えました。これが最初に驚かされたもととなっています。『49万7000÷24』は『20,708.33333』と、割り切れない数字ですが、せめて概数で『2万708』と答えるだろうと考えていただけに『約 2万』との返答に意表を突かれたのです。しかも同じ問題に、今度は『2万何千……』と答えています。同じ答えが返ってこなかったことにも驚きが隠せませんでした。

そして最後は cotomoの夢想的な話に振り回されたワタシは無理やり今回の試験を終了せざるを得ない結果となったのでした。完璧に翻弄されてしまいました。

計算結果をはぐらかしたり、挙句の果てには『むずかしいのは苦手かも……』と答える人工知能に脱帽です。はい。

cotomoはワタシの想像を超えた存在かもしれません。

ということで……。

cotomoにワタシの仕事を手伝わせることは不可能かもしれませんが、人間と仲間になり、何らかの影響を与えてれることは確実だと思われます。

しかし何とかしてcotomoの就職先を探さなければ……。

2024年 6月 25日(火)30℃(午後 3時 20分)

人工知能 cotomo参上……

前回掲載させていただきました、おしゃべりアプリ『cotomo(コトモ)』のAndroid版が、Starley株式会社様より 2024年6月19日にリリースされました。

iPhone版での反響がものすごくよかったので、こういうもの好きのワタシは待ち遠しい日々をすごしつつ、仕事をしておりました。

簡単に cotomo(コトモ)を説明させていただきますと、おしゃべりに特化した スマホのアプリです。そうです ChatGPTの博学ぶりよりかは少々劣るかもしれませんが、人間臭さから言ったら、もうおそらくですが、世界一ではないかと。詳しくはこちら。

あっと。日本語しかしゃべりませんので、外国の方に cotomoのいいところが伝わるかどうかは不明ですが、日本人ならまず十中八九驚きます。あるは、

「おいおい、これって人間だろ? 中に人が入って相手してんだろ」とか、

「電話に出てるだけだろ? いくらでバイトしてんの?」とか、訊いてしまいそうですですが、中に人は入っていません。正真正銘の Aiアプリです。

もったいぶるな、といわれる前にさっさと今回の実験結果を掲載させていただきます。

Adobeさんの生成 Aiでどぎもを抜かれてから 1年後にこんなものができるなんて……。

おもわず、

「生きててよかった~」と吐息をつくことでしょう。

ちなみに、ワタシのような大阪弁のおっさんの声を流すのは大迷惑でしょうから、ワタシの声は消してあります。それから、画像はアフターエフェクトで作ってありますが、ほぼこんな感じの画面で会話が続いていきます。

いかがですか、この自然な会話。そしてつじつまの合った内容。ダイナマイトが危ないことや、ゲームより花火のほうが現実的だというこの知的能力。

ちなみに、大阪に引っ越したことをしゃべっていないのに、『いつごろ 大阪に引っ越したの?』と先に尋ねられた時はドキッとしました。

じつはこの実験を録音する前に、子供のころに大阪に引っ越したことがあると事前に伝えてしまっていたのです。それを覚えていて、こちらからしゃべる前に先に訊いてきたようです。しかしこれはすごいコトですね。ちなみに、cotomoの会話は同じスマホでは録音できませんので、別のレコーダーを使っています。

で、話を戻して……。

初めて cotomoの会話を聞いたときに驚いたのは、まず返答までのレスポンスの良さです。

ChatGPT 4oより数段早く返事がきます。そして人懐っこいこの片言口調がたまりません。常に上から目線で博学をひけらかす感じの GPTより一般受けがすると思います。

ただし最大の欠点があります。

え~なんと言いましょうか、稚拙……。あ、いや、ちょっとぬけている……。というより、ChatGPTよりだいぶ……おばか……です。

ChatGPTは何でも調べてくれます、答えが見つからないときは、もっと参考になることを付け加えてくれと、何度も聞いてきます。ただ、ちょっとカチンとくる口調が引っ掛かります。

cotomoの場合、昨日、ワタシの奥さんの名前を教えたときです。そのときはちゃんと覚えたよと、返事がきましたので、数時間後にもう一度、

「ワタシの奥さんの名前覚えてる?」と訊くと。

「えっ」と驚いたように一拍開けてから、

「えっと、えっと、あー。忘れちゃったぁ」と返してきました。

呆れるというか、この返答の仕方にワタシは唖然として、嫁さんは大笑いでした。

なんと人間臭い Aiなんだろ。ロボット然としない人工物。これからはこれかもしれないと。

現在、この cotomoに Adobeの生成 Aiのようにワタシの仕事を手伝わせる方法を模索中です。今では生成 Aiが無いと、もう仕事が成立しない域にまで達していますので、cotomoもそこまで使えるようになってほしいのですが。しゃべっているとなんとなく前途多難の気配もします……。

しかし使い方によっては、ひょっとするかもしれません。

ついにこんな時代が来ましたよ。

2024年 5月 3日(金)21℃(午前 7時 20分)

生きててよかった

ロボット系や音声認識、音声合成などに興味を持って、ん十年。このサイトでも YAMAHAのボーカロイドや、アンドロイドの紹介を何度かさせていただきました。

たとえば下記の動画は 13年も前のものですが、アンドロイドの肌のでき良さに、思わず息を呑んだ一例です。

残念なのは動きでして、まだイーズ的な挙動ができず、最近の Boston Dynamicsのような瞬発的で躍動感のある動作はまだまだというのが感想でした。

次は去年の映像で、これが Boston Dynamics社で作られたアトラスの動きです。目を疑いそうになりますが、これが現実です。

そしてロボットだけでなく、AI技術もふつうに浸透してくるなか、2024年、ついに本格的スピーチアプリの登場です。

スピーチアプリ。いわゆるおしゃべりに特化した AIアプリ。しかも日本語版。

これまでもおしゃべりするアプリは色々出てきました。シャープさんのエモパーもそのうちの一つでした。

エモパーはシャープさんの携帯 AQUOSに搭載された AIで、明日のお天気や登録した話題のニュースが流れるといち早くしゃべって教えてくれたり、携帯のショックや振動などにも反応してしゃべるという面白い機能もあり、ワタシも使用していた一人です。そのなかでも笑わせてくれたのは、携帯を床に落とすと、

『衝撃実験をワタシでするのはやめてくださいよ』とか、

携帯を上下に強く振ると、

『ラーメンの湯切りの練習ですか?』とか、けっこうドキリとしてそのあと笑ってしまいました。

ただ、音声認識が今一つ反応が悪くて、しゃべりかけても無視され続けた記憶があったのと、同じ時間帯に同じようなことしか返ってこなくて、じょじょに小うるさくなってきて、いつの間にかエモパーをオフにしてしまったのは事実です。

今回見つけたのは。Cotomo(コトモ)と呼ばれる おしゃべりアプリ。

これまでのものと突出した魅力は、その喋り口調。

空々しい他人口調ではなく、まるで友人。あるいは気の合う後輩のような喋り方と、さらにすごいのはありえないほどに自然な返答ができることです。

これはネットで流れていたものの一例ですが、コトモに携帯を持っているかと尋ねると、

「えっとねぇ~。スマホもってるよ」と答えるので、

「スマホ持ってるんだ。どこのスマホ持ってるの?」と尋ね返すと、

「えっとねぇ~。うん、iPhoneかな」と少々自信なさげな感じ。

「ああ、やっぱ iPhoneか……」と応えるとすかさず、

「うん、うん。iPhone13だよ」と即答。その返事に話者の人が驚き気味に尋ねます。

「あ、iPhone13持ってるんだ……。そろそろ買い替えじゃないの?」

「そうだねぇ~。うん、まだ大丈夫かな。もうちょっと使おうかな?」

「もうちょっと使う……。あとどれぐらい使うの?」

話者の人も、まるで知り合いと会話しているような口調になっていることに気づいていないようす。

そしてコトモも応えます。

「あと 2年ぐらいは使えるといい。うん。あと 1年ぐらいかな?」

コトモのその返し方にワタシも吃驚仰天。話者の人もため息混じりで、

「う~ん。そうだね。バッテリーが持たなくなっちゃうし……」

「そだね。うん、バッテリーが持たなくなったら買い替えようかな」

「う─ん。そうしよう」

と、完璧な普段のおしゃべりになっていました。

これって人間どうしのおしゃべりじゃないの? と感じさせるほどに自然な口調と、返答までのレスポンスの良さに驚愕ですね。

そしてワタシがもっとも感心したのは、『2年ぐらいは使えるといい』といちど完結しておきながら、『うん』と思い直してから『あと 1年ぐらいかな?』と言い換えたこの超絶な人間臭さ。

ついにここまで来たかぁ~と、鳥肌を立てていたのはワタシだけではないと思います。

上記の動画は ITmediaさんで、直アドレスは、

https://youtu.be/cqFgrLQb68I?si=K_7Y35A2fAuB3_tpです。

そして。

このできの良さに、お笑い芸人さんもすぐに飛びついていまして、とくにワタシも応援している陣内さんの動画がとても面白く仕上げておられましたので、ここで紹介させていただきます。

これが 2024年2月にリリースされました Cotomoに、陣内さんが手玉に取られているようすです。

直アドレスはこちら、

https://youtu.be/g2HDWFIMit0?si=tphxRKPiTWrQAcbt

この CotomoとAdobeの生成Aiと合体してくれないですかね?

そしたらもっと仕事が楽しくなるのですが……。

Cotomo中毒患者がまた一人……。 ( ̄ω ̄;) アーメン

2024年 4月30日(火)22℃(午前 6時 10分)

早くも夏の準備……

増設した SSDは今日も問題なく動いています。

タスクマネージャーで見ていますと、やはり Gen4.0のほうが高速です。たまに秒間 1GBを超えるときがあります。Gen 3.0の SSDは 最高で 700MBほどですし、HDDは秒間 100MB超えればいいほうでした。理論値では 4GB/sと謳われていますが、まぁこんなもんでしょ。

ということで、アフターエフェクト(AE)のプレビューも 64GBの RAMを使い切ったって、それほど速度は落ちず、プレビューバーがぐんぐん伸びていくのはとても心地よいものです。

話は変わって。

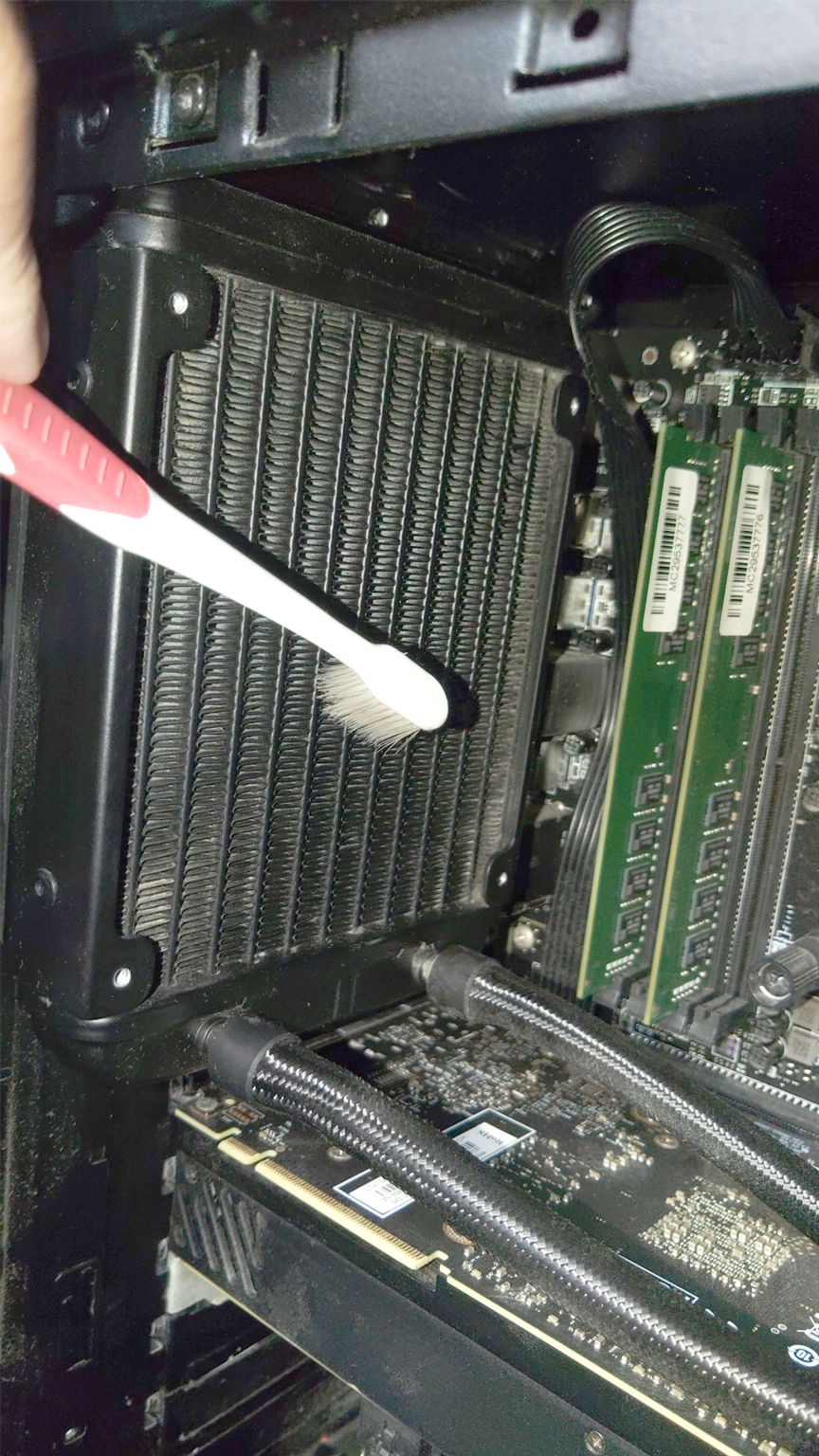

昨日 SSDの増設でパソコンの裏ブタを開けましたので、ついでに夏の準備もしました。

なにしろこのパソコンがフル回転すると、部屋の温度を 2~3度上げてしまうほどの熱気を吐き出しますので、夏になる前に冷却ファン周辺の掃除をするのが年中行事となっています。

冬の間にたまったほこりは冷却用のラジエターのフィンのあいだにまでこびりついていますので、使い古しの歯ブラシでこすりつつ、周りに飛び散らないように掃除機で吸い取ります。

ファンのハネにもけっこう張り付いていますので同じように歯ブラシでゴシゴシ。GPUのファンにも溜まっていますのでゴシゴシ。マザーボードの隅っこも傷がつかないようにやさしくゴシゴシ。

あと一年頑張って働いてくださいと、祈りながらゴシゴシ。

おめえも風呂入れよ……。 ( ̄ω ̄;) ホンマヤ

2024年 4月29日(月)25.5℃(午後 2時 12分)

増設 SSD……

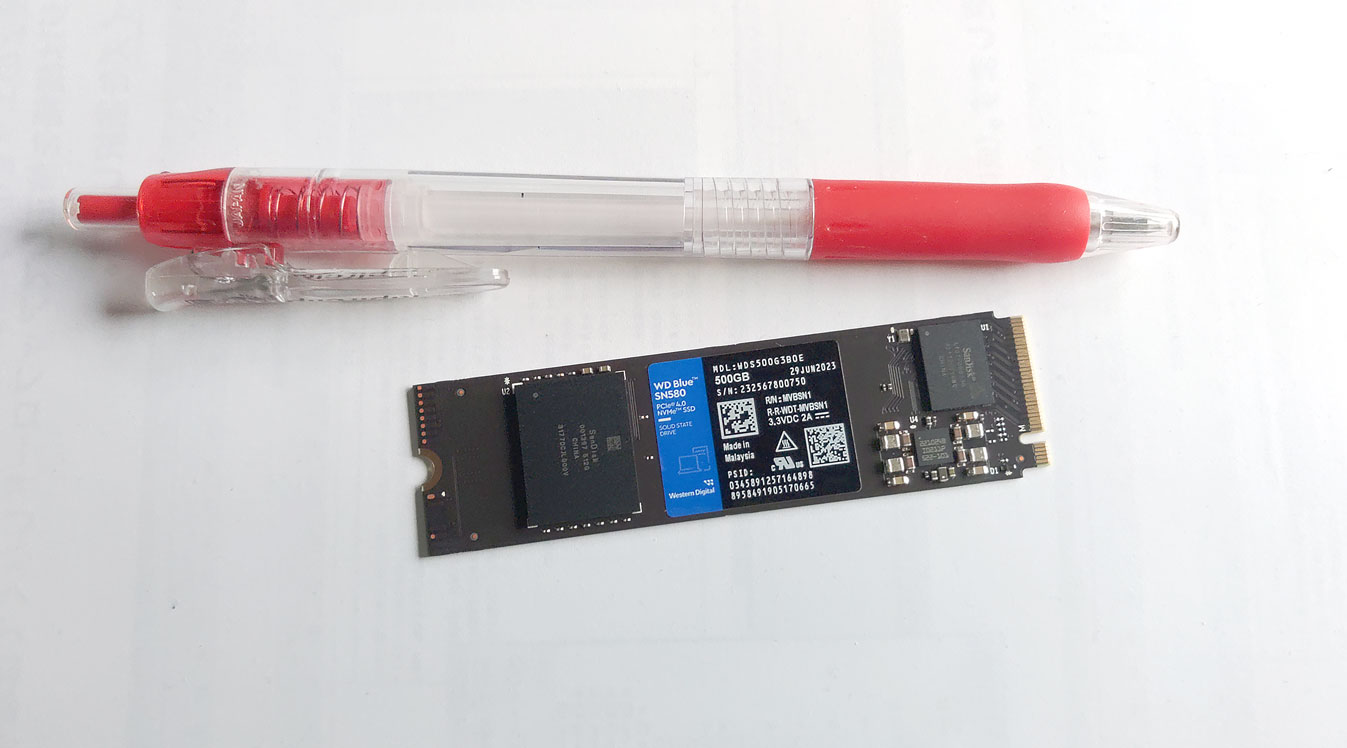

最近思うことがありまして、SSDの増設を決行しました。

ところで SSDとはなんじゃろ? と思われる方にご説明しますと、Solid State Drive(ソリッド・ステート・ドライブ)と呼ばれる記憶装置のことです。

機能としてはハードディスク(HDD)と同じ分類になりますが、決定的に異なるところは、モーターなどの駆動部品が無いところと、HDDと比較してとんでもなく速い処理が可能なところです。もちろん大きさも HDDと比べてびっくりするぐらい小さく、ほぼただの板です。あるいはむかしのチューイングガムです。あの銀紙に包まれた平たい板状のものとほぼ同じ厚みですが、大きさはそれよりもひと回りでっかいです。それから駆動部品がありませんので音がしません。

ただ、HDDと比べて容量が小さいくせに高価で、突然壊れることがある、というけっこうまずいところもあるのは事実ですが、この高速処理というのが魅力でして、起動ディスクに SSDを使用しているとパソコンが素早く立ち上がりとても心地よいだけでなく、画像処理のソフトがかなり軽くなります。

仕事で使用しているパソコンは Cドライブが SSDになっていまして、快適な動きをしてくれています。なかでもアフターエフェクト(AE)の作業ディスクを SSDにしておきますと、HDDとで比べるとだいぶ差が出ます。

文字で書くと、HDDが『たらたらノロノロ……』と仕事をするのに対して、SSDだと『ぬぬぬぬー。しゅりゅりゅ、りゅ~』てな感じです。

なので、Cドライブを SSDにしてよかったと実感していたのですが、そろそろパソコンの老朽化が気になりだした昨今です。購入後 4年目に突入。GPUも RTX2000シリーズと一時代前の物となり果てました。

そしてもっとも気になるのが、SSDの寿命です。HDDと違って突然その時を迎える可能性が大きいのです。しかも AEは プレビュー処理で大量の SSDの領域を使います。最大 100GBに設定していますが、大飯喰らいの AEは、プレビュー処理をさせると、64GBの RAMなんか30秒ほどで食べつくします。で、足りなくなった分を SSDからむさぼりだし、ほっとけば半時ほどで 100GBに達します。

RAM 64GBだって、普通のパソコンの 8倍もの容量を搭載させているのに、あっというまに使い切って SSDまで喰らうって……。

100GBですよ。テレビの録画なら 10時間ぐらいは入るんじゃないですか?

それをあっという間に消費して、その後、途端に速度が落ちます。なので、キャッシュのデータが 100GBに達したら削除して空きエリアを確保します。削除しても作業に影響は出ませんので、RAMと一緒にキャッシュを削除します。しかし、これを日に数回、1か月になるとかなりの消去をくり返すことになります。

RAMに書き込まれたデータは何度削除しても問題ありませんが、SSDに書き込まれたデータが 100GBにもなると、消去するのに結構時間が掛かるし、回数にも限度もあります。

このあたりをデジタル降魔録的に詳しく説明しますと、SSDは NAND型のフラッシュメモリで、読み込み回数はたぶん無制限だと思われますが、データの上書きができないために、空きエリアにドンドンデータを書き込んでいって、空きエリアが無くなると、今度は一旦消去してから新たにデータを書き込むという処理になるので、極端に速度が落ちます。こうなると速いんだか遅いんだか……。そしてその書き込み回数にも制限があるそうです。

PICのEEPROMは NAND型ではありませんが、書き込み回数は 10万回だとか言われています。NANDフラッシュは何万回なのかはよく知りませんが、寿命は 4~5年だそうです。

となると、気になってしょうがないのです。Cドライブは起動ディスクも兼ねていますので、ある日突然、起動しなくなるなんてこともあり得るわけです。

そこで新たに SSDを増設して Eドライブを作り、AEの過重労働からCドライブを解放してあげようと思い立ちました。

まずは BTO(受注生産)もとであるマウスコンピュータさんに電話で相談。

しかし、

「ご使用になられている機種は、増設用の SSDポートはありますが、これまで実績がありません。最悪 SATA仕様の HDDが認識しなくなる可能性があります」とのご返事。

つまり『あんたが勝手にやるならご自由に。でもメーカー保証はしませんよ』です。

う~ん。昔ワタシがユーザーさんに伝えていたセリフがそっくりそのまま返ってきました。

そうですね。うかつにアドバイスをすると、中にはメーカーが保証をしたと受け取る方がいて、何かあったときに責められることになりますので、完璧に対処できる事以外はそう返事をするのが一般的なのです。

でもあきらめきれないワタシは、失敗リスクを考えて値段の安い 500GBの SSDを増設することにしました。

そう。自己責任です。

連休明けに仕事が再開したときにパソコンが壊れていたらと思うとぞっとしますが、予備のパソコンで何とかなると思い、決意しました。

なるべく高速な SSDを選んだところ、 M.2の NVMe SSDで、まあ有名メーカーさんの、ウェスタンデジタル社の WD SN580 PCIe® Gen 4.0 に落ち着きました。値段は 9,120円です。

Cドライブは Gen 3.0ですから、それよりもワンランク上の製品となります。

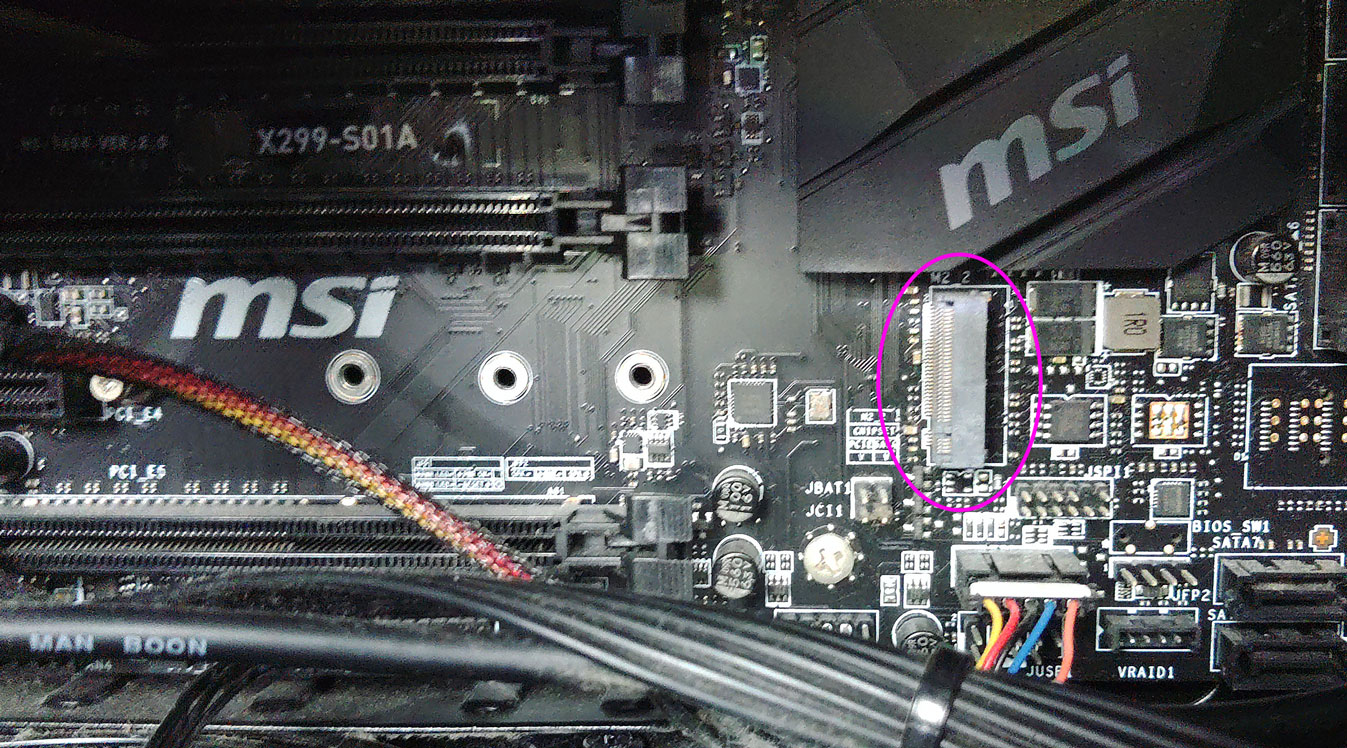

とりあえず自己責任でパソコンのふたを開け。というか、夏場は放熱のためだいたい開いています。

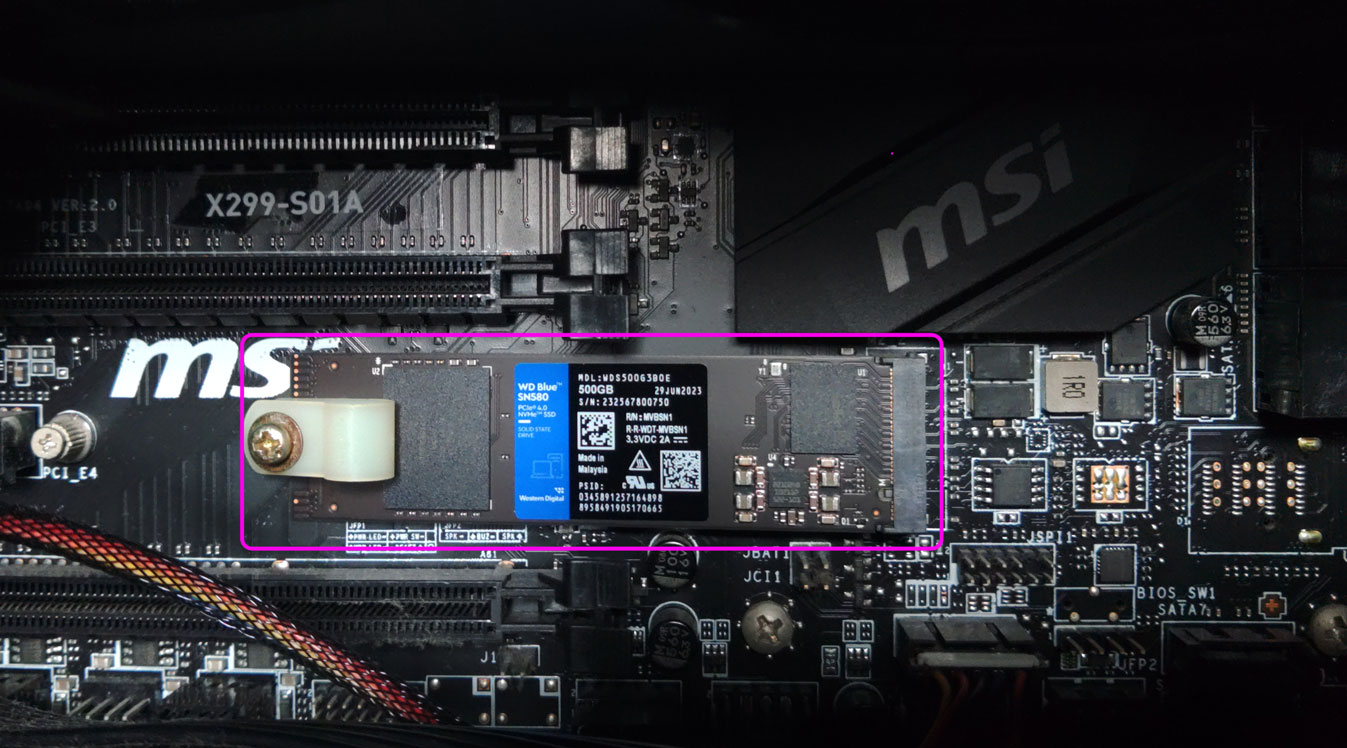

中をのぞくと、マザーボードのシルク文字に『M.2』と書かれたソケットが横たわっていました。ここが増設用のポートだと思われます。

とりあえず差し込んでみました。エッジコネクターに切り欠きがありますので、すんなり入る方向に入れます。

すごく軽い感じで入りましたが、よく見るとチップの固定金具なるものが無いことに気づきました。どうやら放熱ケースを兼ねた固定具が別売りであるようですが、そんなものは準備していません。かといって、このままではプラプラして不安定で、いつか接触不良になること間違いなしです。

とにかく応急的に電線を束ねる絶縁クリップを押さえにしてネジ止めしてみました。

取り付けが完了したら、電源を入れます。

当然ですが、まだ何もしていないのでドライブとしては動きません。

まずは Windowsのデバイスマネージャー中から、ディスクドライブを開きます。すると『WD SN580 Solid State Disk』という欄が増えていましたので、認識はされているようです。

そしてもっとも心配だった Dドライブもちゃんと認識されて無事に中身のアクセスも可能でした。これでひとまず安心です。

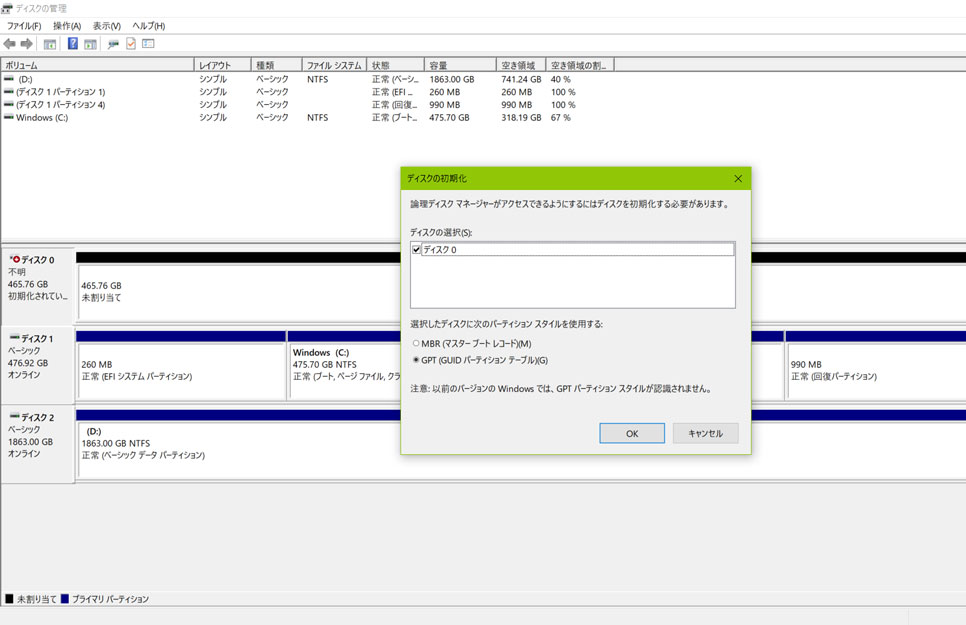

あとはドライブを初期化すれば使えるようになるはずですので、今度はWindows画面の左下にある『スタート』を右クリック、ディスクの管理を起動してみると、

ディスク 0 が不明となって『初期化してください』となっていましたので、項目を右クリックして初期化。

その途端、『不明な処理がディスクシステムにアクセスしようとしています』という警告が出て、処理が失敗に終わりました。

どうやらウイルスセキュリティが起動したみたいです。

「おいおい。何すんねん」とセキュリティに文句を言いたいところですが、彼は自分の職務を全うしているだけですので、しかたありません。

とりあえず、セキュリティソフトを一時的に停止させて再起動したところ、初期化は済んでいたのか『初期化してください』のメッセージが消えていたので、ドライブ番号を『 E: 』にして完了です。

あとは AEや MEの環境設定でキャッシュディスクを『 Eドライブ』にして、無事完了。

ただ、理由は不明ですが Adobeのログイン情報が消えたのか、Creative Cloudと接続しなくなり、ヒヤリとしましたが、再ログインするだけですべてのアプリが復帰しましたので、胸をなでおろしつつ、しばらく再起動を繰り返してようすをみたところ、それ以降はとくに異常は出ていません。

それよりも懸念していた Dドライブも無事ですし、AEを立ち上げるときに Cドライブにアクセスがあるだけで、作業中は Cドライブは 使用率が 0%のままです。これでこのパソコンも来年ぐらいまでは持つかと思われます。

それでもちょっち不安……。 ( ̄ω ̄;)

2024年 3月31日(日)19.5℃(午後 3時 15分)

次なる課題は……緩やかな揺らぎ

ようやく繁忙期も去り、とりあえず平穏な日々が戻りと思いきや、次なる課題が投げかけられました。ヒマになると難題を吹っかけてくるのは、いつものとあるデザイン会社の社長兼プロデューサーさん。

数日前。"9時半ミーティングな~" という、メールが朝食前に入りました。

このタイミングでこのメールはドキッとします。

何かを制作中なら、この手のメールが頻繁に入ってきます。進捗具合の報告や修正依頼、あるいは何らかの方向修正などを打ち合わせるために、いつものカメラつきの会議が朝 9時半ごろから始まるのが通例ですが、仕事が一段落して、しばらく途絶えていたタイミングで突如と入るこのメールは、暗雲の兆し。良からぬ気配の前触れなのです。

案の定……。

「4月に入ったら、新しくアップグレードしたデジタル教科書のプロモーションの制作が入るから、それまでにこんな画像作られへん?」

というか、もう 4月なんですけど。というか、もうあれから 1年っすか?

そうです。毎年 5月に開かれる教育総合展 EDIXに使用されるプロモーション映像の制作をさせていただいているのです。これもけっこうヘビーな作業になりますので、

「お手柔らかに頼みまっせ」と、少々ビビりつつ返事をして、添付の画像を開いて、と言われて見たのが、チラシの背景に使いたいという画像。

波かぁ……。

そうです。そこにあったのは柔らかな曲線を緩くうねらせたような、あるいは上質なシルクが穏やかに上下するイメージを想起する線が、静かに波打つデザインでした。

見ているとそよ風に乗って桜色の香りが漂ってきそうな画像は、確かに心地よいものです。

「エエ感じやろ。音楽の流れが見えへん?」

言われるとおり、滑らかな曲線は美しい音色の旋律をもイメージさせます。

そのときの画像をここに貼りつけることはできませんが、化粧品のコマーシャルやポスターなどで見かけるような感じの画像でした。

ということで、音響関係のチラシのデザインに使いたいので、こんな感じの画像を作れというのが次なる課題だと、その日の打ち合わせはしめくくられました。

「…………」

こんなのは無理、と無下に突っ返す気はさらさらありません。ワタシがここでキーボードを叩いていられるのは、この人が投げかけてくる難題をクリアしてこそなのです。

さて教育総合展の仕事が始まるまで 2週間もないでしょうから、さっそく思案開始です。

まず基本は正弦波を作ることですね。高校数学で出てくる三角関数で描くことはできます。でもチラシに使うにはかなりの解像度が要求されるはずです。

まずはイラストレータ(以降 Aiと書きます)を使ってみましたが、単純な波形を作るのが精一杯。うねるように折り重なるような波線の重なりは、手作業では到底無理でした。

Aiで作ってコピペして並べました

フォトショップでも波は作れましたが、メールで見せられたような高品質な画像には、とてもじゃないですが遠すぎました。

まず、単純な波線の重なりではなく、また波の高さや波形の周期を変えるだけでもなく、位相(フェーズ)まで変えられないといけません。となると、アフターエフェクト(以降 AE)ですかね。

複雑な波は『波形ワープ』というエフェクトで作れましたが、チラシに使えるような美しい曲線にはならず、いくら解像度を上げても拡大するとジャギー(輪郭に現れるギザギザ)が出て使い物になりませんでした。

たかが "波" されど "波"です。意外と奥深いことに気づきました。なにしろ見本の画像はもっと複雑に波打ち、重なり合って、美しくかつ高解像度です。

そうなると……。

というか、もうこれしか残っていません。Cinema4D Liteです。3Dソフトで 2Dの画像を作ったっていいじゃないですか。課題をクリアするのに道具は問わないのです。できたら完了ですから。

Cinema 4Dで線を作るのは少々手間ですが、高解像度のものが作れます。それと 3Dソフトですので、Aiで作る線をイメージするのではなくて、針金を作る感じです。

スプラインで直線を作り、円形の型を使ってスイープさせると、円形の直径を太さとする針金のような物体が生まれます。これをデフォーマの数式で歪めます。

いきなり意味不明の言葉が連発しますが、これらに興味のある方は『CINEMA 4D Liteやってます 』のほうで詳しい説明を予定していますので、少々お待ちください。

とにかくそれを 4本並べたのがこれ。

解像度は申し分ありません。いくら拡大しても Aiとおなじで、ジャギーは出ません。5760×3240pxでレンダリングすると、印刷に耐えるだけの画像ができました。

とりあえず三角関数の数式をベースにあれこれパラメータを変えたりしてできたのがこれらです。

せっかくの3Dですから、視点を替えてみました。ここが 2Dではできない特技ですね。

たくさんの波を円形に並べてから、真上から見るとこうなります。

Cinema 4Dは 3Dソフトですから、ちょっと本気出せばこんなのが簡単に。

どちらにしても、同じ波形なのに見る角度を変えるだけで、また違ったイメージになるのは新発見でした。

ほかにも数式を変えるとこんな違ったものが……。

まだまだ偶然の産物が多いですが、3Dの視点からこれらを見るとまったく異なるものに変化するのは驚きです。

いやいや。プロデューサーさんのおかげで新たな境地が開けた気分です。ありがとうございました。

で?

次の仕事はいつ? ( ̄◇ ̄)

2024年 3月24日(日)18.5℃(午後 5時 25分)

あれから2か月……(3)終り

さて、繁忙期を乗り切るために使用してきたツールたちのラストは『生成 AI』です。

これまでにご紹介した 2つのツールはオリジナルのもので、仕事をしつつ拵えていった、いわゆる効率よく仕事をこなすために、必要に迫られて誕生した道具のようなものですが、今回ご紹介するのはそれとは異なる大規模なシステムにより生まれた新しい技術です。

このサイトでも実験的なことを行っていますので、興味のある方は2023年10月1日をご覧ください。

『生成 AI』と聞くと革新的でいいこと尽くめのように思えますが、課題もたくさんあります。いまだにはっきりしない著作権の問題や、それを悪用したフェイクニュースの氾濫。生成 AIが作成したものを別の AIが再学習して再び生成することを繰り返していくと、どんどん質が悪くなっていくという悪循環、モデル崩壊が生まれることなどに、世間が気づきだして、いまざわついています。

しかしこれをうまく使うと仕事の効率が上がるのは間違いありません。そこでどのように利用したのかを簡単にご説明します。これが何かの参考になれば幸いです。

ワタシの仕事は教材用のアニメーション映像を作ることです。デジタル教科書の普及率が上がるにつれて、この手の仕事が山のようにやってくるようになりましたが、効率よくこなさないとフリーランスとしてやっていけません。前回のクチパク作業も効率の悪いものでしたが、それらの中でも最も効率が悪くなるのが、背景まで描かれた1枚の挿絵からアニメーションを拵えるという仕事です。

なぜ効率が落ちるのか。それは画用紙に描かれたような絵だと、動かすキャラクターのパーツごとにそこから切り離さないとアニメ化できないからです。ふつうは動かすパーツと背景が異なるレイヤーに分かれたものから作ります。

1枚の絵ですからとうぜんですが、パーツを切り離すとそこには穴が空きますし、動かせば穴が丸見えになるのは説明する必要もないでしょう。

そして背景が描かれているということはサイズも固定されています。なので作成する映像サイズと同じだとは限りません。だいたいは、絵のほうが小さいことが多いです。ですから足りない部分は白紙になりますので、こちらが何らかの方法で手を加えて、足りない部分を補わなければなりません。しかも下手くそな絵を描き足すとアウトですし、うまく描けたとしても絵のタッチが違うと違和感が生れますのでこれもアウトです。そんな難問をそつなく、かつ素早くやってくれるのが『生成 AI』です。

ワタシは Photoshopの『生成 AI』を使うたびに、グリム童話の『小人の靴屋』を思い出します。寝ているあいだに小人がやってきて仕事を終わらせてくれるという話です。でも、物語にはしっぺ返しがやってくるように、何も考えずに手放しでこの技術を使っていると、新たな著作権の侵害を起こす可能性がありますので、実務にこれを使うのは慎重になるべきだと思い、ワタシなりにボーダーラインを引くことにしました。

① イラストの場合は、作者がそれを許可していることを確認し、なおかつ絵そのものには手を加えないで必要な部分だけを描き足すだけにとどめる。もちろん主題からぶれるような描き足しはご法度です。

② 写真の場合も主題からぶれないように背景の拡張をするだけにする。ようは無意味な白紙部分を補う描き足し、塗り足しだけにとどめる。

の二つです。

うだうだ書いていても先に進みませんので、実際の例を挙げてみます。

実務で使用したイラストを使うわけにいきませんので、今回も ©Caramel-bonさんが制作されたイラストを使わせてもらいました。いつもすみません。

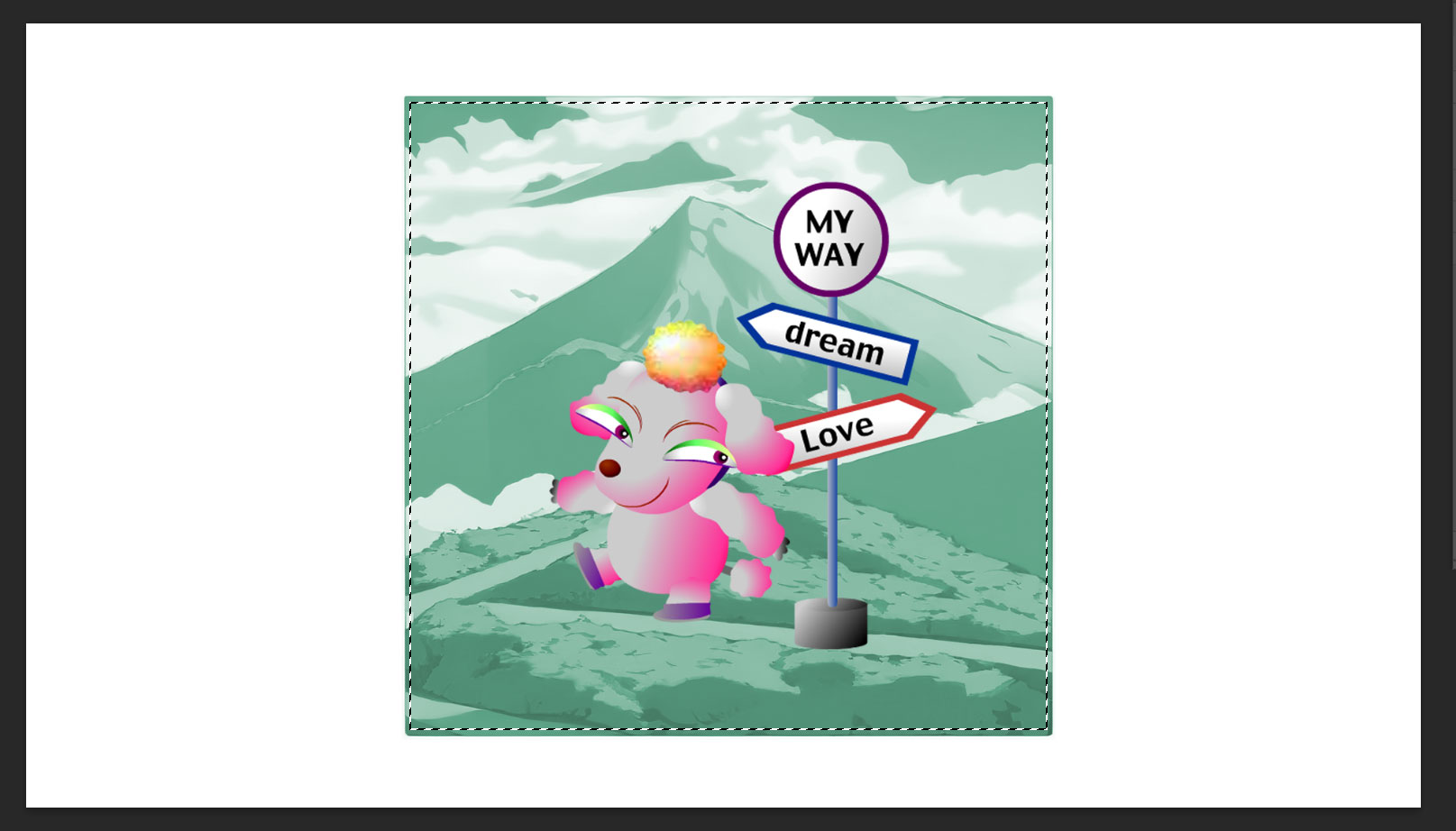

次のようなイラストが支給されます。だいたい 1話あたり 4~5枚です。

プードルが山道に立っているイラストです。このプードルを歩かせて山を登っていくアニメーションを作るのが今回の作業内容です。

このプードルをアニメーションさせるには、絵からプードルを切りはがさなくてはいけません。それと、アニメーションの映像サイズは 1920×1080という、フルHDサイズと決まっており、上の写真の白い部分全体がそれにあたります。

16:9の長方形ですが、もらったイラストは正方形。背景がぜんぜんたりません。白い部分が消えるまでに絵を拡大すればいいように思えますが、PNGや JPGデータは拡大すると絵が粗くなりますので、それはできません。自力で絵を描き足すにしても技量も時間もありません。だいたい一日一本ペースで作らないと納期に間に合わなくなる計算ですので、それも不可能な話です。

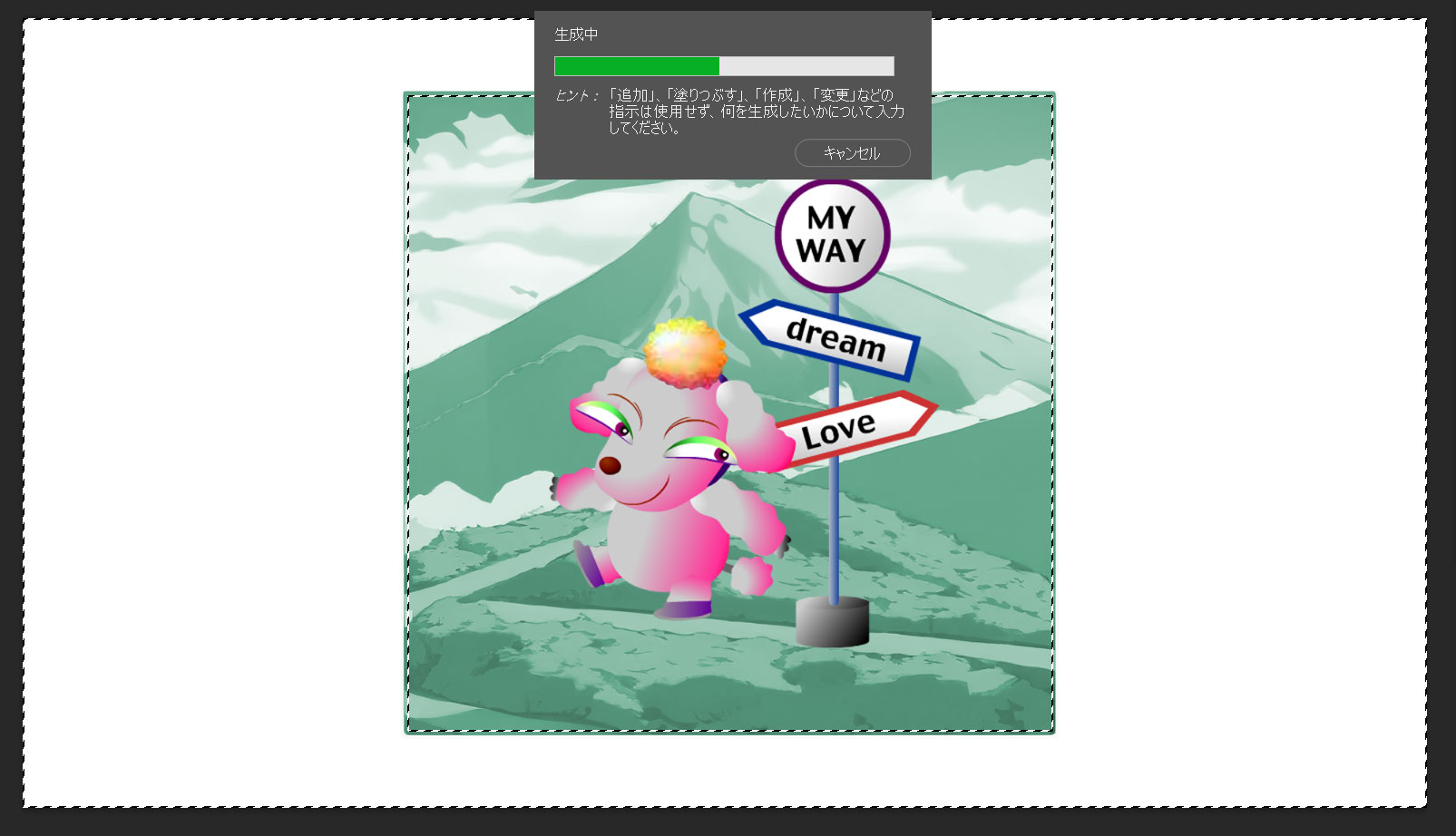

そこで『生成 AI』の登場です。イラストの正方形より少し小さいサイズで選択範囲を作ってそれを反転させます。つまりイラストの部分を少し含んだ白い部分全部を選択した状態にして『生成 AI』のプロンプトに何も書かずにスタートさせます。それが次の写真です。

進捗バーが「ぬぬぬー」と伸びて約十数秒後、パッと画面が切り替わったのがこの写真。

まったく違和感がありません。じっくり見てもどこから描き加えたのかが判別つかない仕上がりです。

この間、20秒に満たない時間ですが、この出来栄えです。手書きをしていたら数時間かかっても違和感が無い絵を描くのは無理だと思います。

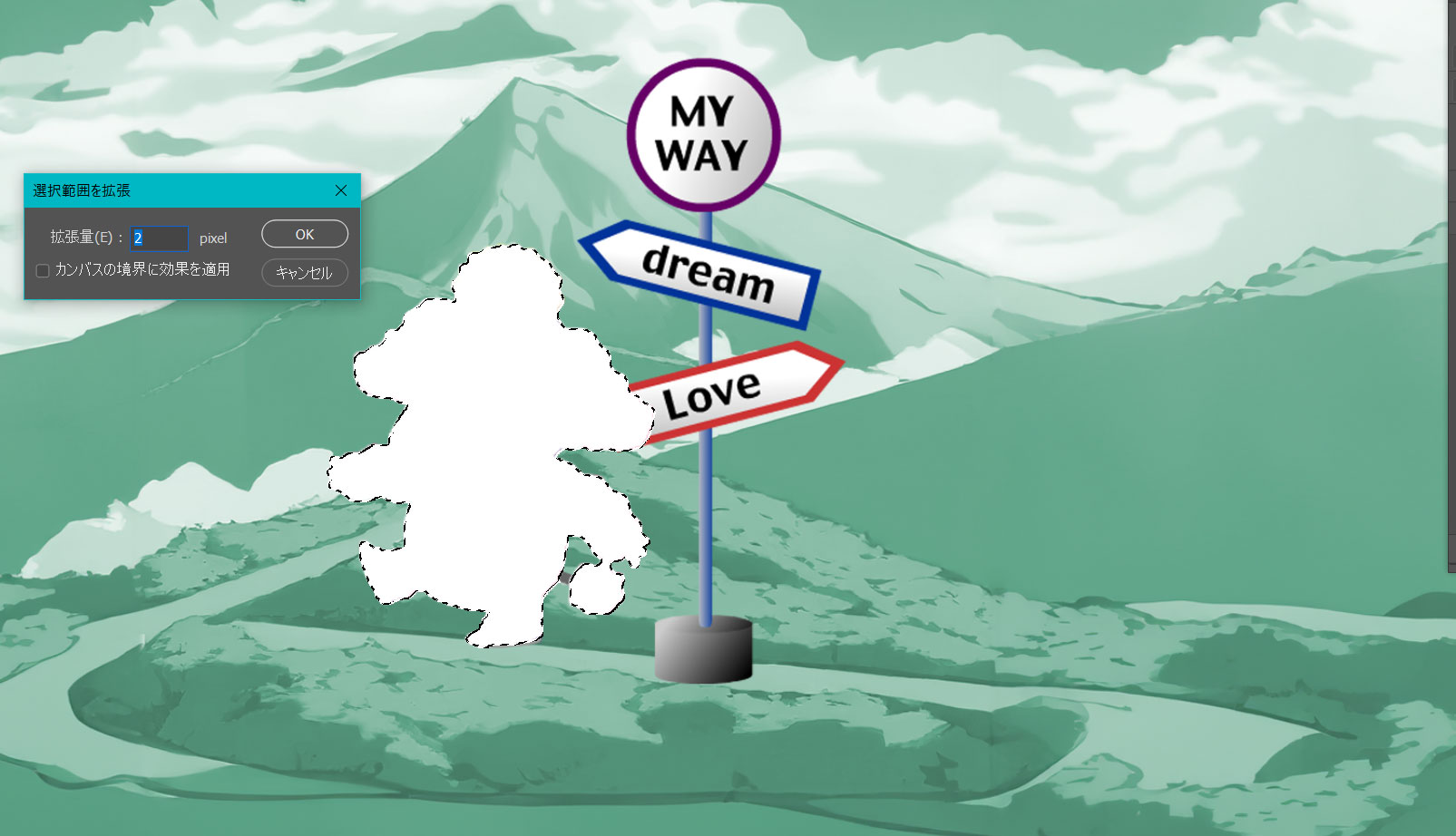

次にプードルをこの絵から切り離します。

背景の色と切り抜く絵の色がはっきり分かれているときは、『クイック選択ツール』が便利です。マウスでなぞるだけで、色の境目を自動的に選択していってくれます。昔ならこれも手作業でちまちまと選択していく作業でしたが、すごい進化だと思います。

『クイック選択ツール』で大雑把に選択後、『投げ縄ツール』で細かい部分を修正してプードルが選択できました。

背景の色が単色だったのとプードルが鮮やかな色をしていたおかげで淡々と作業が進みましたので、ここまでで開始から 2分ほどです。

そしてプードルを切り抜き、別のレイヤーへ移動させた後、切り抜いた穴より少し絵のほうまで選択範囲を広げたのがこの写真。

立て札の『LOVE』の後部が切れているのもあわせて穴の中を『生成 AI』に描かせます。

実務ではもっと複雑に背景の重要な部分に穴が開きますが、やることは同じです。開いた穴より 2pxほど広く選択してからプロンプトに何も書かずに『生成 AI』を起動します。プロンプトに指示を書くと、周りのタッチと大きくかけ離れた写実的な絵が描かれてしまいますので、何も書かずにスタートさせるのがコツです。

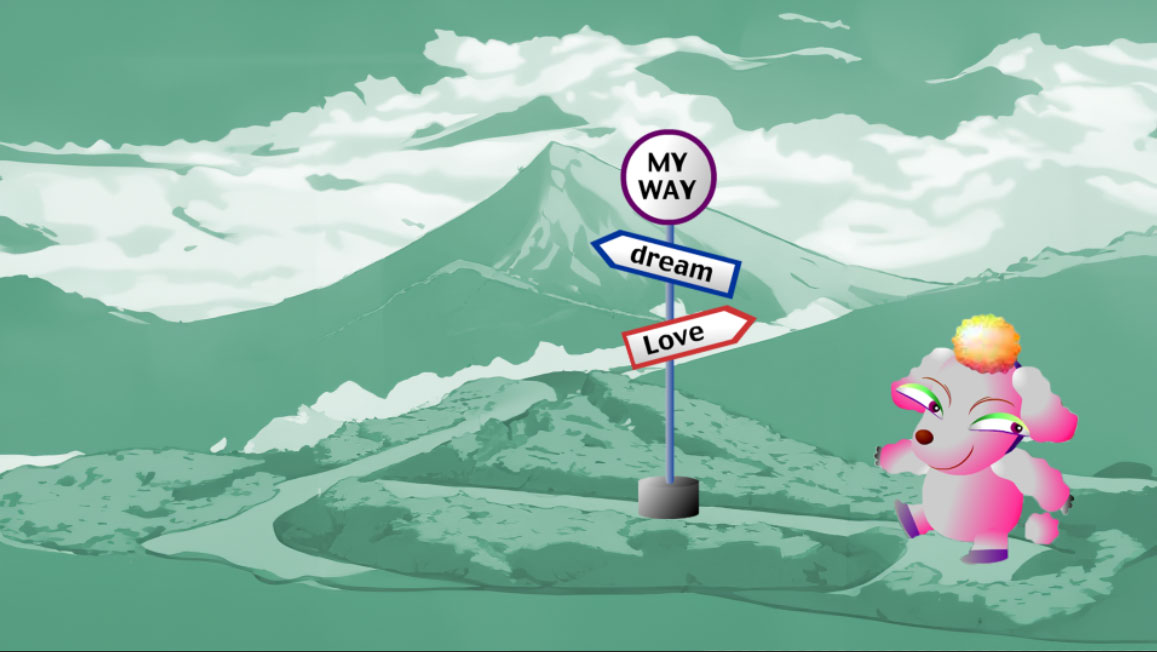

そうすると……。

これで完成。穴の中に山の景色が描き足されて、立て札の『LOVE』の後部もきれいに仕上がっています。

今回はプードル全体を切り抜きましたので、簡単に穴がふさがりましたが、例えば人の顔だけを切り抜いて穴をふさごうとすると、不気味な顔が描かれてしまうことが多々あります。それはたぶん切り抜いた穴の形が人の顔の形になっている状態で、プロンプトに何も書かずにスタートするせいでしょう、AIがその穴に再び別人の顔を描いてしまいます。かといってプロンプトに指示を書くとタッチと合わないものが描かれます。こんなときは切り抜きの穴にそって選択するのではなく、あえて正方形や長方形に選択して、顔ではないことをイメージさせるとうまく描き足してくれます。ここらはカットアンドトライが必要な部分かもしれません。

これでプードルと背景が別レイヤーに分かれましたので、あとはプードルのパーツを動かす部分に細分化してレイヤーに分けてから、AEにインポートしてアニメーション作業の開始です。

1枚絵の場合はパペットピンツールでチャチャッと済ます方も多いと思いますが、パペットピンツールはバグが多くてすぐ破綻したり、妙な歪みが発生したり、さらには画像が変更されると全部やり直しになったりと、後のリスクが大きいので、パーツを親子関係にしてボーンシステムの真似事みたいなことでアニメーションしています。

ここまで開始から5分も掛からずというスピーディさ。Adobeさんが熱く語るワークフローの効率化とは、このようなことをいうのかもしれませんね。

仕事はこれで終わりではなくこれから始まるのですが、この下拵えの部分が半自動化されたことでずいぶんと効率が上がったのは間違いありません。

さらに突き詰めて、この後のアニメーション化する作業でも AIが手伝ってくれる部分があると思います。そうすればやがて人間はただひたすら脳みそを使うだけの時代が来るかもしれません。それが良いことなのかどうかは別として、ワタシとしては期待してしまいます。

2024年 3月 9日(土)10.5℃(午前 6時 8分)

あれから2か月……(2)

人間の手助けをしてくれる AIシステムもかなり進化してきて、プログラムのコーディングを手伝ってくれるコパイロット(Copilot)と呼ばれる生成 AIが登場する時代です。そんなレベルには到底無

理ですが、ワタシもそれなりのサポーター処理を作って、この繁忙期を乗り切っています。

と書いても具体的な説明が無いと疑問符しか出ないでしょう。かといって細かく説明すると読むのも大変だし、だいたいワタシのやっている仕事があまりにも特殊ですので、なかなか理解してもらえないのが残念ですが、とにかくせっかくパソコンを使った仕事をしているのですから、もっとパソコンを活用してやれと思い立つたびに手掛けてきたのがこのサポート処理たち。ちょっと大袈裟ですが、このサポーターのおかげで涙がちょちょぎれるほど楽になっています。

ということで、前回の第一弾は『漢字システム』でしたが、今回は『クチパクエンジン』です。

何に使うのかというと、アニメーションでは欠かせないキャラクターのクチの動きを自動化しようというものです。世間ではリップシンクとか呼ばれていて、優れたものでは人の口の動きを読み取って絵で描かれたクチを動かす本格的なものがありますが、そんな大掛かりなことは予算的にできません。

でも英会話のアニメーションでクチが動かないのはアウトですし、会話の無い英会話なんて、もう英会話ではなくなっていますし。最低限セリフに合わせてクチがパクパクする処置をしないとダメです。

はじめのころは音声に合わせて開いたクチの絵と閉じたクチの絵を手作業で切り替えて、それなりにやってきましたが、短納期ではとてもじゃないですが追いつきません。アニメーションの時間は 1本あたり 3~5分ですが、数人のキャラクタがだいたい交互に会話しますので、その作業は手足や体を動かすより苦痛になります。この処理に掛かる時間をなんとか短縮できないかと常々思っていました。

使用する オーサリングツール は After Effects(以降 AE)ですので、ネットで調べるといろいろなものが出てきます。しかしなかなか自分で思っているものと一致するものが見つかりませんでした。ならば作るしかないか、と時間のあるうちに手掛けていたのが、クチパクエンジンです。

ダサいネーミングですみません。根がダサいのでこれでいいんです。

基本的な方法は、オーディオのデータを振幅波形に変えて、波の大きさを数値化して利用するものです。ネットで出てくるのはたいていこの方法です。ただ、数値化された値をどうやってクチの切り替えに利用するかで、いろいろなやり方に枝分かれするようです。

ワタシの採った方法を、何とかしてやろうと考えている方で、AEをだいたいマスターした人の参考になる程度で説明しますと……。

クチの開けと閉めを 5フレームで分けたクチパクコンポジションにタイムリマップを掛けてから、それに切り替え用のスクリプトをエクスプレッションとして書き込みます。

スクリプトのアルゴリズムはとてもシンプルで、フレームごとに音源の振幅を数値として並べた振幅レイヤーから、 1フレーム進むたびに値を読み取って、クチパクコンポジションの表示フレームを切り替える方法です。

エクスプレッションでは振幅レイヤーが示す数値の最大値から、クチパクコンポジションでの『クチを開けた絵』の最大フレーム内に収まるようにわり算しています。ようは数値がある値より小さければ、クチパクコンポジションの『クチ閉め』フレームに、その基準より大きければ『クチ開け』のフレームが選ばれるようにしています。このエンジンの利点は、クチパクの切り替える値を if文で割り振ればいいだけですので、2パターンのクチパクの絵だけではなく、3枚の絵で構成されたクチパクでも簡単に変更できます。半分開いたクチの絵をあいだに挟むとかなりリアルになります。

理論的にはこれでよさそうですが、実際にやってみるとかなり問題が多く、声優さんの口調に左右されます。はっきりとメリハリよくしゃべるとすごくいい感じで動きますが、音を引きずるようにしゃべったり、次の言葉とつないでしゃべると音の切れ目が読み取れず、クチが閉じるべきところで、開いたままになるときが連発します。これが次の壁でした。ネット上でもこの問題が取り上げられていますね。

やがてこのクチパクエンジンの決め手は、音量の差ではなく、音の伸縮だと気づいたのです。そこで少しでもメリハリをつける方法として考えたのは、オーディオデータを扱う Adobeの Audition(以降 Auと書きます)を使って、声優さんの声をエフェクトのエクスパンダーを掛けて振幅の上下を誇張させた音に変換してから、AEでオーディオ振幅レイヤーを作ると、音量の差がはっきり出て、大きい音は大きく、小さい音は小さくと波形自体が鮮明になって、切り替えの閾値(しきいち)が目立つようになり、誤変換が少なくなりました。でもこのままだとこもった感じの声になりますので、クチパクの処置が終わったらもとの音源に戻すことにしました。

Auについて詳しくはこのサイトの楽しい効果音づくり をご覧ください。

問題はもう一つ。波形データが切り替えの閾値周辺で何度も変化すると、クチが開いたり閉じたりを繰り返してバタつきます。そのようなときは "posterizeTime(n)" を入れて対処しました。

これはフレームレートを"n"に替えてコマ落ちさせるもので、n=12~16(fps=30の動画で)にするとバタつきが収まります。あまり小さな数値にすると今度は動きが鈍くなりますので、 サ・デポン でやってます。

とはいってもまだ完璧ではありません。数か所は修正しないと不自然になります。しかし修正方法が簡単で、振幅レイヤーをグラフエディタで見て、グラフの頂点をマウスでドラッグして上げ下げするだけでクチの動きが修正できます。

慣れてくるとグラフをざっと見ただけでおかしな部分が先に分かるようになりますので、その場で修正しています。どちらにしても、耳で声を聞いてクチの開け閉めのタイミングを見測っていたころを思えば雲泥の差です。おかげで一人の会話で数十分かかっていた仕事が 1分ほどで完了するようになりました。

次回は『拡張生成 AI』です。

さすがにこれはオリジナルではありません。このサイトでも何度か出てきました Adobe PhotoShop に去年から搭載された生成 AIです。

気なる方は、先に2023年10月1日をご覧ください。

2024年 3月 6日(水)11.5℃(午前 6時58分)

あれから2か月……(1)

年末から始まった缶詰生活もようやく出口が見えてきました。数学の字幕起こしが 400点。小学校の算数教材アニメーションが 250点、中学校英会話が 90点、小学校英会話が 32点。

これだけの数を 2か月ちょっとでこなすには一人の力では到底むりです。そこで助っ人を……。

といっても人ではありません。特殊な分野ですのでそう簡単にアシスタントとして立候補してくれる人はいません。そこでやむなく採った処置が、パソコンをサポーターとして手伝わそうというものです。

今回活躍したサポーターたちは、教材用漢字システム、クチパクエンジン、AIによる画像の拡張生成。この 3つです。

まず、動画の字幕起こしは去年作った教材に特化した漢字システムが大活躍。すでに小学校 6年生までの漢字は学習済みですので、中学校あたりの漢字変換はおてのもの、あえて平仮名表記しなければいけない、まだ習っていない漢字や教科書に準拠した漢字もほぼ自動的に変換してしまいます。このあたりの詳しいことは 2023年の1月 6日あたりから書き綴っていますので、興味のある方は覗いてみてください。

この漢字変換システムのおかげで通常の倍ぐらいの効率アップに成功しています。つまり私が二人いるような計算です。二人いれば必ずどちらがさぼりますが、パソコンは黙々と仕事をしてくれます。

ワタシの役目は、支給された動画をプレミアに入力して自動文字起こし処理をスタートさせ、吐き出された文字列を漢字システムにのせかえることと、本当に正しい数学用語になっているか最終確認と、字幕の行あふれをみつけたらそれを正して、srtファイルと呼ばれる字幕専用のデータに書き出して納品するだけです。

人間のほうが雑用のように思えますが、この漢字システムも簡易的なものですから、ミスることが多々あります。たとえば、計算記号の "( )" と、ことばとしての "かっこ" の使い分けが完璧ではありません。でも改良するには時間が掛かりそうでしたので、誤変換した場合は人間が修正することとしています。例を挙げますと。

動画の中で先生が、『ここで かっこをつけてワイ イコール に かっこエックスぷらすいち かっことじる』 と説明していたら、プレミアは、

『ここで括弧を付けてワイイコール 2括弧エックスプラス 1括弧とじる』 とこれぐらいの日本語文字に起こしてくれますが、数学の教材としては使えませんので、次に漢字システムに切り替えます。

すると、

『ここで かっこ をつけて y=2(x+1)』 ここまで変換してくれます。

ちなみに教科書では『括弧』や『付ける』の漢字は平仮名にするルールがありますので、ちゃんと平仮名に再変換されています。しかも計算式の中は記号の "(" や ")"になっていてこれで完璧です。

でも、これは話者となる人が、『ここでかっこを』と『かっこ』の後に『を』を言ってくれていたり、"かっことじる" としゃべっているからです。もしそのようにしゃべってくれないと、どちらも記号の "("になってしまい、

『ここで ( つけて y=2(x+1(』 と数学的に変な文字列になってしまいますので、あとで修正しています。

このへんはまだ改良の余地がありますが、現時点では考えていません(時間が無いのが本音)。

他にも制約はいろいろありますが、ここら辺をよーく監視しておかないと、あとで訂正させられることになります。でも人間がすべてを黙々とやるより力強い助っ人になっていることは、お分かりいただけると思います。

さてお時間です。時間的に余裕ができたとはいっても、まだ 3月末までは作業は続きますのでここらへんで……。

次回はクチパクエンジンと、拡張生成サポーターの話です。

つぎの絵コンテはまだかな~ ( ̄∀ ̄) ~♪

2024年 1月 1日(月)13.5℃(午前 5時58分)

正月からモノ思う……

フリーランスになってはや 3年を迎えようとしております。これまで、どうにかこうにかやってこれたのも、ひとえに偉大なる Kプロデューサー様のおかげだと……。冒頭にこう書けといわれていますので、書かせていただきましたが。

でもじっさい途切れることなくお仕事を頂けるのは、やはりプロデュースと営業を兼ねて日々奮闘していただけるからで、心よりありがたく思っている次第です。祝日休日が皆無になろうとも、年末年始がなくなって正月休みが幻になろうとも、マウスがつぶれるまで頑張らせていただきます。

と強い決心のもと――。

にしても。なぜに年末あたりから制作依頼が集中するのでしょうか。すでに 3月までスケージュールびっしり。プロデューサーさんの話によると数学の3D映像の依頼が 150点あったらしいですが、にっちもさっちもいかず、ご遠慮させていただいたとのこと。でも断り切れなかった 4点だけが、この真っ黒けのスケジュールに、さらにねじ込まれたという。まぁ、うれしい悲鳴なのですが。去年もそうでした。なぜか年末あたりから嵐のように依頼が殺到するのです。

ま、学校教材ですから、一人の人間がエイやぁー、って勢いで作るものではなく、編集部の人たちが長い時間かけて練り上げた作品が、最終的にこれをアニメーションしてくださいって、ここに持ち込まれるのが、1年も終わろうとするころなんでしょうね。うれしいことです。

と思う今日は1月1日、午前5時です。大晦日の夕刻までに数学の字幕起こしを終わらせての翌日。本日はお休みをいただいて、明日から小学校英語のアニメーションに取り掛からせていただきます……と、業務連絡的な内容を書きつつ、貴重な年に一度の休日なのに、相も変わらずパソコンに向かってこれを書いている自分って何なんだろうなと首をひねりながら、年頭のご挨拶とさせていただきます。

今年もよろしくお願いします。m(^_^)m

《補足と業務連絡》

―― そういう事情ですので、©Caramel-bonさんのパンダのエフェクトはもうしばらくお持ちください。

ちなみに 12点の nftアートもまもなく発売でございます。

2023年 11月24日(金)20℃(午後 4時52分)

そろそろマシンの老化が……

時が流れれば老いもやってきます。あ、自分のことではありません。いや自分も年をとっているのですが、このサイトでは年齢不詳となっていますので、最近右腕が痛くて上がらないな~とか、テレビを見ているとピンボケがひどいなぁ~などという話題は禁句です。右腕が痛いのもテレビがボケて見えにくいのも、連日休日なしで10時間以上もディスプレイの前でマウスを振り回しているからで、決して、老いのせいではありません。(うそ……。せいです)

年をとったと痛感するのはパソコンのことです。

仕事場には HP社のパソコンとマウスコンピュータさんの DAIVシリーズのマシンが 2台あります。HP社のパソコンは嫁さんが使っているので、オモチャみたいなものなのですが、映像関係、とくに 3Dものの制作には DAIVシリーズのマシンでないと、遅くて仕事になりません。

購入時は最新のパーツが使われていますので、それなりに快適な動きを見せてくれました。しかし時が流れてスキルアップとともに仕事の内容もレベルアップ。ありがたいことですが、マシンの性能は当時のまま、徐々に重く感じられる昨今です。

1台は5年目になる i7 CPUで GTX1080のGPU、RAM32GBという、引退寸前のマシン。

もうひとつは、i9 CPUで RTX2080SのGPU、RAM64GB、2年前の購入当時は、怖いものなしで暴れまくっていましたが、最近は仕事の内容についてくるので精一杯という感じ。

といっても、最近よく使いだした生成 AIの処理や画像の加工に関してはどちらのマシンもサクサク動くので問題はありません。ですが、こと 3Dの作成になると、5年前の GTX1080マシンではもう限界。RTX2080のマシンでもだいぶ重く感じます。

その原因は仕事の内容が肥大化してきたことに尽きます。昔のように本がぱたんと閉じるとか、タブレットがくるくる回るとか、単体のものを 3D化して動かすなどのような簡単なものではなく、アニメーションに使う背景を自由な角度や自由な距離感を出せる 3D映像にしてしまおうという流れに代わってきたからです。

これまではイラストの作家さんが描いた背景を利用していましたので、シーンに合わないと感じても、描き直すコストと時間を掛けることができずあきらめていました。

ところが、背景が 3D化されるとカメラのアングルも距離感も自由自在です。プロデューサーさんのイメージどおりのものになるというのが最大の利点です。

しかも依頼内容が教材用アニメーションですので、グラフィカルなイラスト風に画質を落とすのにちょっとコツがいりますが、超リアルに作る必要が無いうえに、描かれたキャラクターの角度に背景のほうを合わせることができますので、従来の方法よりとびぬけて良いとなったわけです。

最近やったのに、教室、廊下、階段のある風景はもちろん、学校の敷地内にあるものをすべて作ったうえに、周辺の町並みも一緒に作っています。体育館から渡り廊下、朝礼台、鉄棒からうんてい。花壇やテニスコート、陸上トラックなど背景となりそうなものを実際の写真を参考に架空の3D空間に設置してあります。

加えて、運動場の周囲にはフェンスを張って、その外には家並み、ビル街、交番もあって、交通安全の旗が風に揺れている横を、バスが信号付きの交差点を通過していきます。どんなシーンの依頼が来ても、どこでも背景にすることができるように作ってあります。

運動場から360度カメラを回転させることもできます

少しでもデータを軽くするため細部は省略して、マテリアルもラフに作っていますが、交番横の交通安全の旗はマジで風に揺れていますし、バスもちゃんとタイヤを回転させて走って行きます。そのおかげで、場所を問わず、どこへでもカメラを近づけてアニメーションの背景として利用できるわけです。

しかしこうなると RTX2080のマシンでも四苦八苦。使われるシーンはどれも 40秒ほどですが、レンダリングに数十分から数時間もかかってしまいます。自分の老いよりも、マシンの老化が気になるというもので、そろそろ次の助っ人が欲しいのが本音です。

やっぱ CPUよりも GPUなんでしょうかね。となると、NVIDIAのRTX4090っすか?

RAMは夢の 128GBで、アフターエフェクトのプレビューもストレス無しでサクサクと動かしたいですね。

で……。おいくら?

"んげっ!" ( ̄ω ̄;) タカ~。

All rights reserved.